HPAリソースの定義

HPAリソースの定義

ここからは、HPAリソースの定義方法を説明します。HPAリソースに定義する内容は、主に以下の4つです。

| 項目 | フィールド | 内容 |

|---|---|---|

| スケール対象 | .spec.scaleTargetRef | スケール対象リソースのapiVersion、kind、nameを指定。基本はapiVersion: apps/v1、kind: Deploymentを指定 |

| スケール範囲 | .spec.minReplicas .spec.maxReplicas |

スケール時のPodのレプリカ数の最小値と最大値を指定 |

| スケール条件となるメトリクス | .spec.metrics | スケール条件にするメトリクスを指定。CPU/メモリの他にカスタムメトリクスも指定できる |

| スケール時の振る舞い | .spec.behavior | スケール時のリードタイムとレプリカ増減のポリシーを指定 |

実際のHPAリソース例は以下です*1。

*1: セッション当時はHPAリソースをapiVersion: autoscaling/v2beta2として解説しましたが、この記事では最新のapiVersion: autoscaling/v2を用います。そのため、セッション資料とは異なるフィールドや値が存在します

apiVersion: autoscaling/v2

kind: HorizontalPodAutoscaler

metadata:

name: php-apache

spec:

scaleTargetRef:

apiVersion: apps/v1

kind: Deployment

name: php-apache

minReplicas: 1

maxReplicas: 10

metrics:

- type: Resource

resource:

name: cpu

target:

type: Utilization

averageUtilization: 50

behavior:

scaleUp:

stabilizationWindowSeconds: 60

policies:

- type: Percent

value: 100

periodSeconds: 15

scaleDown:

stabilizationWindowSeconds: 300

policies:

- type: Percent

value: 10

periodSeconds: 60

- type: Pods

value: 4

periodSeconds: 60

selectPolicy: Maxこの定義を先ほどの表に当てはめると以下になります。

| 項目 | フィールド | 定義 |

|---|---|---|

| スケール対象 | .spec.scaleTargetRef |

php-apacheという名前のDeploymentが対象 |

| スケール範囲 | .spec.minReplicas .spec.maxReplicas |

最小レプリカ数が1、最大レプリカ数が10 |

| スケール条件となるメトリクス | .spec.metrics | Podの平均CPU利用率が50%となるようにレプリカ数を調整 |

| スケール時の振る舞い | .spec.behavior | 後述 |

スケール時の振る舞いについて補足します。上記の例では、以下の定義になります。

behavior:

scaleUp:

stabilizationWindowSeconds: 60

policies:

- type: Percent

value: 100

periodSeconds: 15

scaleDown:

stabilizationWindowSeconds: 300

policies:

- type: Percent

value: 10

periodSeconds: 60

- type: Pods

value: 4

periodSeconds: 60

selectPolicy: Maxまずは、スケールアウト時の挙動を説明します。

scaleUp:

stabilizationWindowSeconds: 60

policies:

- type: Percent

value: 100

periodSeconds: 15stabilizationWindowSecondsは、スケール条件を満たしてからスケールを行うまでのリードタイムです。そのため、今回はスケール開始まで60秒のリードタイムがあります。

次に、実際のスケール時の振る舞いです。今回の例ではスケール開始から15秒毎に判定が実施され、既存のレプリカ数を100%としてスケールアウト(ただし、最大レプリカ数を超過しない)します。例えば、現状のレプリカ数が3つの場合は、下図のイメージです。

次に、スケールイン時の挙動です。

scaleDown:

stabilizationWindowSeconds: 300

policies:

- type: Percent

value: 10

periodSeconds: 60

- type: Pods

value: 4

periodSeconds: 60

selectPolicy: MaxstabilizationWindowSecondsは5分(300秒)です。

実際のスケール時の振る舞いですが、2通りのポリシーが定義されています。複数のポリシーが定義されている場合はselectPolicyによってどちらが選択されるかが決定します。今回の場合はMaxなので、削除するレプリカ数が多い方が選択されます。

ポリシーの1つ目は60秒おきに判定され、既存レプリカ数の10%分の数が削除されます。ポリシーの2つ目は60秒おきに判定され、既存レプリカ数から4つが削除されます。

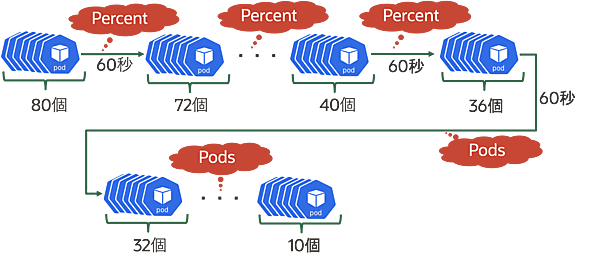

例えば、今のレプリカ数が80個あり、必要なレプリカ数が10個の場合は下図のようにスケールインします。図に示すように、レプリカ数が40個まではPercentポリシー(既存レプリカ数の10%)が選択され、36個以下の場合はPodsポリシー(レプリカ数4個)が選択されます。

- この記事のキーワード