パリで開催されたAI_devから、生成型AIのモデル開発のための統合的なツール群Lightning Studioを解説するセッションを紹介する。プレゼンターはPyTorch Lightningの開発者であるLightning AIのCTO、Luca Antiga氏だ。

●動画:Accelerating the LLM Lifecycle on the Cloud

セッションのタイトルは「Accelerating the LLM Lifecycle on the Cloud」、LLM開発におけるスピードをどうやって速くするか? という内容となっている。

Antiga氏はソフトウェア開発においてコーディング、ビルド、テスト、デバッグというサイクルを速く回すことが重要であり、その要件はLLM開発においても変わらないと説明した。LLM開発におけるトピックがGPUの最適化やモデルのサイズに終始している現状に対して、ソフトウェア開発の原点に立ち返って考えようという視点だ。

PyTorch LightningはPyTorchのラッパーとしてコードの記述にある程度の制約を設定することで、インフラストラクチャー(GPUの指定やログ)の設定や実行を容易にするというツールで、その開発を主に行っている企業であるLightning AIはツール群をオープンソースとして開発している。マネタイズは実行環境として指定されているAWSのリソース(CPUコア数、GPU数、同時実行される開発環境の数)に応じて課金されるというモデルだ。GCPやAzureのサポートも将来計画には組み込まれているという。スライドにある「You do the science, we do the engineering」は「モデルの開発をユーザーが行い、それ以外のインフラストラクチャーなどの設定や用意はLightning AIが行う」ということを端的に示したものとなっている。

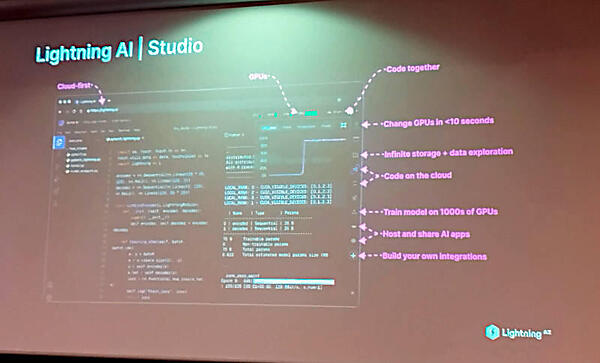

PyTorch Lightningに加えてLightning Fabric、Lightning Thunder、LitGPT、TorchMetrics、LitData、LitServeなどの名前がリストアップされている。ここで特に注目すべきはLightning AI Studioという開発環境だろう。

Lightning AI StudioはAI開発のためのデスクトップ環境と言えるだろう。実態はクラウドインフラストラクチャーのフロントエンドでもあり、Visual Studio CodeやJupyter Notebookなどをプラグインとして呼び出すホストプログラムとしても使えるIDEでもある。また複数のエンジニアがワークスペースとしてコードやデータを共有して開発を行うことを可能にする環境でもある。より詳細には以下の公式ページを参照して欲しい。AIを開発したいエンジニアがやらなければならないことのすべてを一ヶ所に詰め込んで整理したという印象だ。

●Lightning AI Studio公式ページ:https://lightning.ai/docs/overview/studios

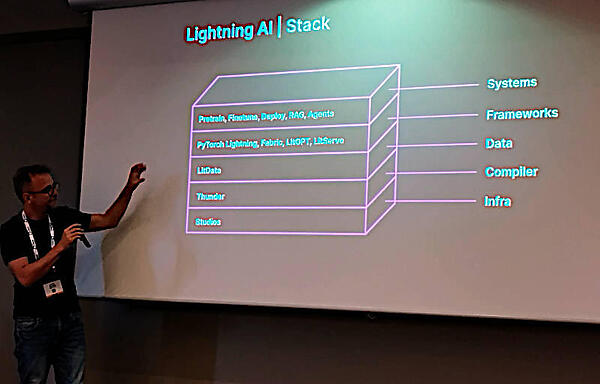

そして上記のツール群をスタックとして表現したのが次のスライドだ。

ここでは一番上位にアプリケーションが位置しているが、それをSystemsとして表現しているのが特異と言えるだろう。その下にフレームワーク、AIのためのデータ、その下にコンパイラーが位置し、最下層にはStudioが置かれているのは、インフラストラクチャーを操作するツールという理由からだと思われるが、インフラストラクチャー層という位置付けになっているのは興味深い。確かにStudioのデモではCPUの数を変更したり、実行環境をCPUからGPUに変更したりすることが示されていたが、一般的な理解とは少し違うことに注意が必要だろう。

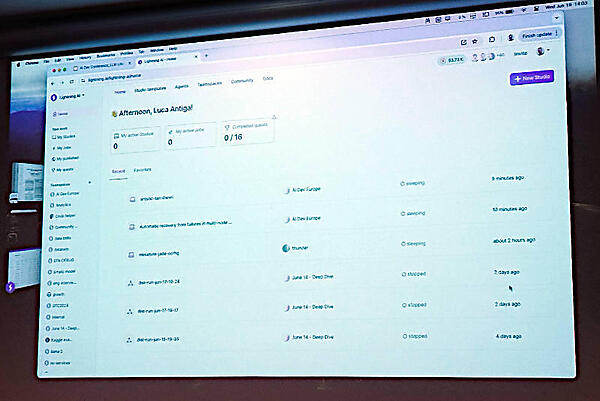

そしてここからはStudioを実際に動かしてデモを行った。

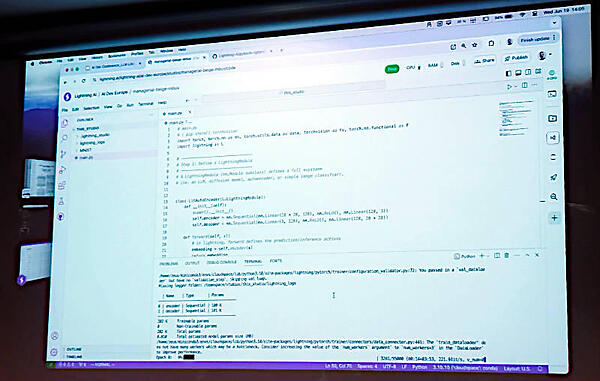

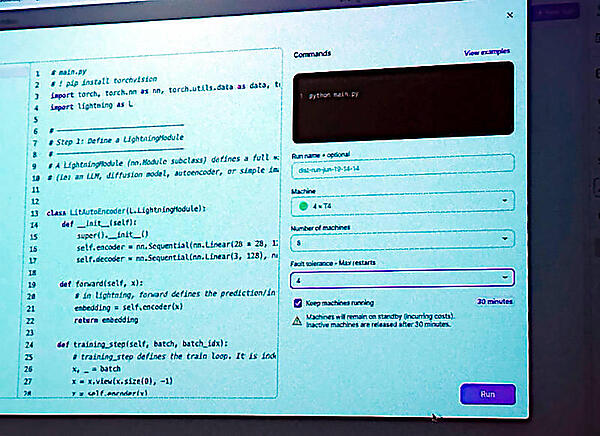

このデモでは実際にコードを編集し、下のターミナルで実行しているところを見せている。

そしてCPUからGPUに切り替える部分もGUIの中でオプションを選択するだけで可能だ。

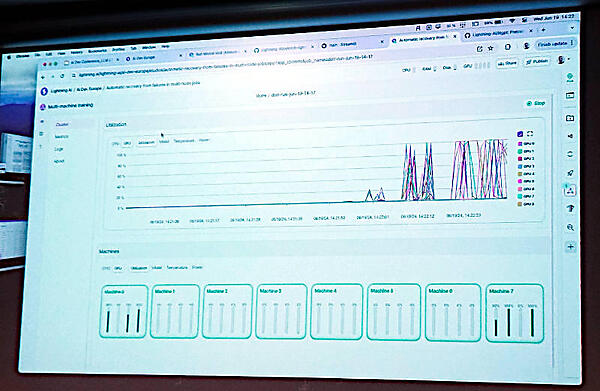

また実行されたジョブの遷移はグラフィカルなインターフェースから確認できる。ここでは8台のGPUで並列処理されているところが可視化されている。

Lightning AIがメッセージとして掲げる「AIを構築するデータサイエンティストは本来の仕事だけをやって、面倒なインフラストラクチャーや設定などは我々が担当する」ということが実際に形になっていることを感じることができるセッションとなった。

会場に設置された狭い展示会場でもLightning AIのブースはいつも参加者が集まって、スタッフが大量の質問に対応していたのが印象的だった。

単にLLMの実行やGPUの最適化だけではなく、AIの開発者がやらなければいけない多くの面倒な仕事をStudioのインターフェースから一元的に管理することで開発のスピードを加速するという目的は果たしていると言える。今度、AWSからGCP、Azureにプラットフォームが追加されることでより使いやすくなるだろう。試用するにはクレジットカードは必要なく即座に開始可能で、GPUについても1ヶ月に22時間まで無償の処理時間が設定されているのはまずは使ってみたいというエンジニアには朗報だろう。

Lightning AIの今後の進化に注目していきたい。