The Linux Foundation(LF)が主催するKubeCon+CloudNativeCon+Open Source Summit+AI_dev China 2024が香港で開催された。日程は2024年8月21日から23日の3日間、香港のKerry Hotelという海沿いのホテルの宴会場を使っての開催となった。4つのイベントのタイトルを冠したカンファレンスとなっているが、クラウドネイティブから生成型AI、そしてLinuxカーネルに関するセッションまでと幅広い分野をカバーする内容となった。

4つのカンファレンスが共催で、広範な分野のイベントとなる

オープニングのキーノートセッションに登壇したのはLFのエグゼクティブディレクターであるJim Zemlin氏だ。

Zemlin氏はオープンソースソフトウェアが世界中のエンジニアのエコシステムに大きな影響を与えていることを強調。この視点はこれまで何度も多くのLF主催のカンファレンスで訴求されてきた内容だが、ここでもそれを繰り返して訴えた。

そしてそのエコシステムはソフトウェアだけに限らず、オープンなインストラクションセットのRISC-V、データエコノミーとも呼ばれる領域(例として、オープンな地理情報データであるThe Overture Maps Foundationが挙げられていた)、そしてSPDXを例に国際標準の領域にも拡がっていると説明。

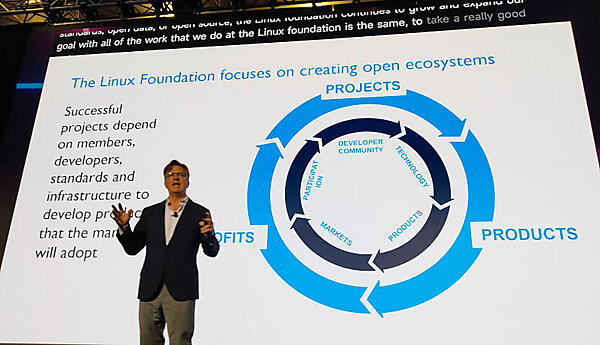

そこからLFがそのエコシステムを拡げるために行っているプロセスを紹介。プロジェクトがプロダクトになり、それがプロフィット(利益)を産むまでをサイクルとして繰り返すことの中心に存在するのは、コミュニティで活動を行うエンジニア、そして公開された標準仕様、さらにこのサイクルを支えるインフラストラクチャーが必要だと強調した。

オープンソースソフトウェアのプロジェクトでは往々にしてエンジニア、つまりコントリビュータだけが注目されがちだが、業界標準、国際標準を常に意識しながらエンジニアがフラストレーションを感じずに開発を行えるインフラストラクチャーの必要性についても解説を行った。

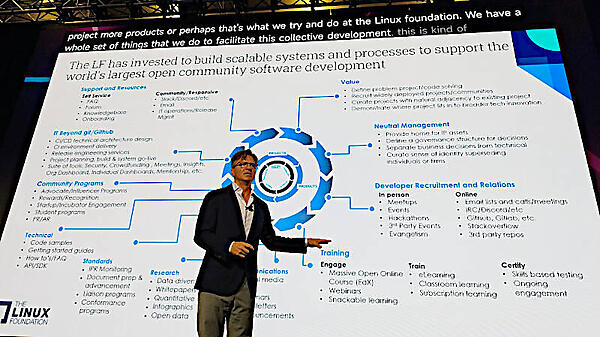

そしてその実証としてLFが関わったプロジェクトについて各要素を紹介。コミュニティのためのツールからCI/CD、メンターシッププログラムから知的財産保護のための管理手法、デベロッパーをリクルートするための仕組みまで、多くの要素を活用してLFがオープンソースプロジェクトを支援してきたことを紹介した。まるで日本企業のスライドのようにテキストがあふれているが、そのぐらいに多くのことを成し遂げてきたという自負が現れているということなのだろう。

その結果として多くのプロジェクトが年率約30%の成長率で拡大していることを説明した。

セキュリティ、ネットワーク、クラウド、自動車、エッジ、Web開発、AI、CI/CDなど、粒度のバラツキはあれども多くのプロジェクト、組織がLFのガイダンスに沿ってオープンソースという軸をずらすことなく成長していることがわかる。

ただ、LFとその配下のCNCFはプロジェクトの活動に常に注意を払っていることも留意したい。実際に企業が提供したソフトウェアがオープンソースとして公開され、活動を始めてはみたものの、活動が滞った場合には冷徹にプロジェクトをアーカイブする選択を行っている。LF/CNCFのプロジェクトとして採用されたからと言って成功が約束されているわけではなく、競合となるソフトウェアが採用されることもあるし、活動を停止させるという判断が下されることもある。あくまでも支援はするが、ガバナンスを行いプロジェクトを成長させるのはそのコミュニティの役目であることを明確にしているところがポイントとだろう。

ここでも注目を集める生成型AI

そして現在もっとも注目されている生成型AIについての解説が始まった。

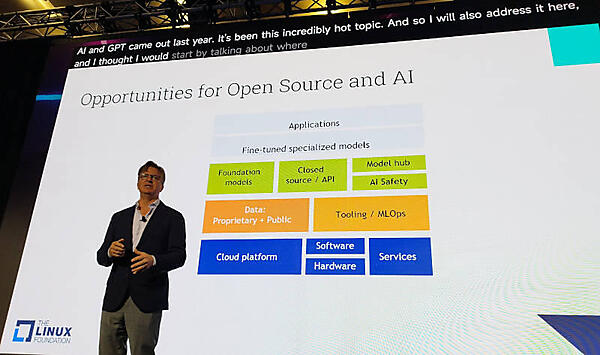

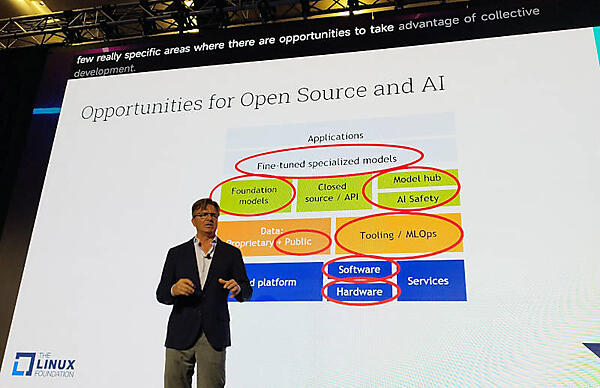

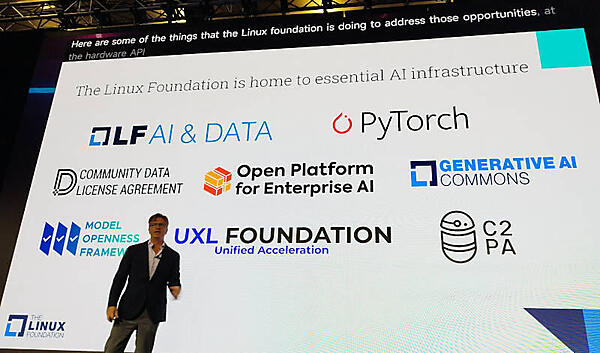

AIのコンポーネントの概念図を使って多くの部分にオープンソースが使われることを強調。ここではベースとなるモデル、学習されリファインされたモデル、モデル公開のためのハブとなるリポジトリ、そして学習のためのツール群などがオープンソースによって実装されていることを説明した。

ここでは敢えてクローズドソースのコンポーネントが存在することを強調した図を使って、MicrosoftやOpenAI、Anthropic、GoogleなどがクローズドなAIにシフトしていることを参加者に意識させる目的があったと言えるだろう。

ここでも複数の組織、プロジェクトとのコラボレーションを行っている例を見せて、LFが生成型AIにおいてもオープンソースによるイノベーションを信じていることを示した。

特にPyTorch Foundationについては、セッションの最後で2024年9月に開催される予定のPyTorch Conference 2024について生成型AIに関わるエンジニアは必ず参加するべき重要なイベントであることを強調していた。またC2PAのようにデジタルコンテンツの信憑性について活動しているプロジェクトについても言及しているように、単にソフトウェアを作るだけではなく消費する部分に関してもオープンであることがいかに重要なのかを示していると言える。

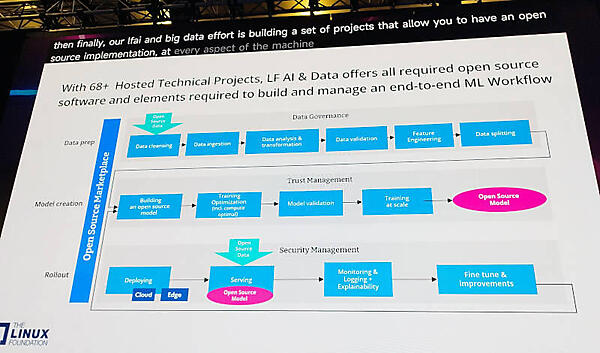

生成型AIについては前のスライドで概念図を示して説明したが、ここではどのようなプロセスを経て生成型AIが造られるのか? を説明。データを用意して、モデルを生成、その後にアプリケーションとして利用していくという流れが解説されている。それぞれデータのガバナンス、信用/正確性の管理、セキュリティの実装というラベルが追加されているのに注目したい。

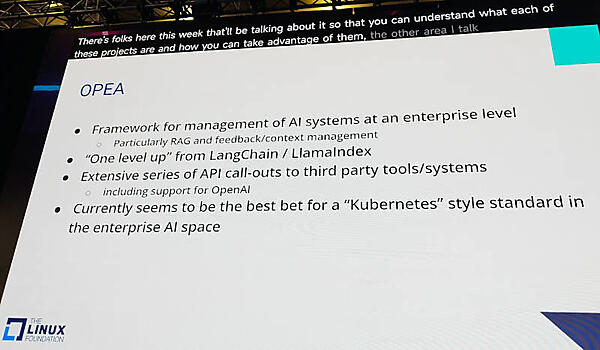

特にLFのターゲットであるエンタープライズにおいては、OPEA(Open Platform for Enterprise AI)というプロジェクトを紹介。LFが「ターゲット」という場合、コントリビュータを多く輩出してくれる母体という意味と、LF配下のプロジェクトを使い、プロフィットを造り上げる組織という2つの意味を持つ。そのエンタープライズ企業が安心して生成型AIを使えるようにするための非営利団体がOPEAだ。

●参考:Open Platform for Enterprise AI

OPEAをざっくりと説明したスライドには、どうしてここでOPEAを持ち出してきたのかがわかる要点が書かれている。具体的には、エンタープライズ企業での実装が最も多そうな対話型AIに特化していること、クローズドなOpenAIについてもAPIから利用できるようにしていること、そして現時点でKubernetesが成功した形に最も近いスタイルでエンタープライズ企業のAI実装を行えそうであることなどである。

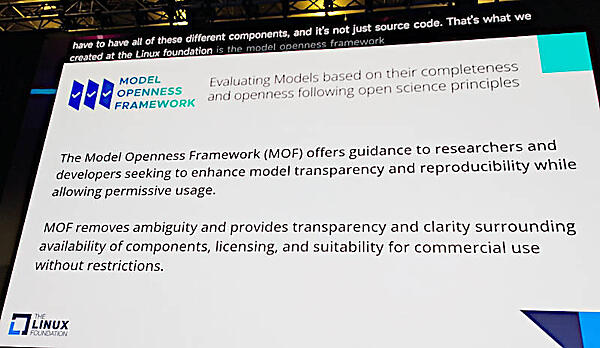

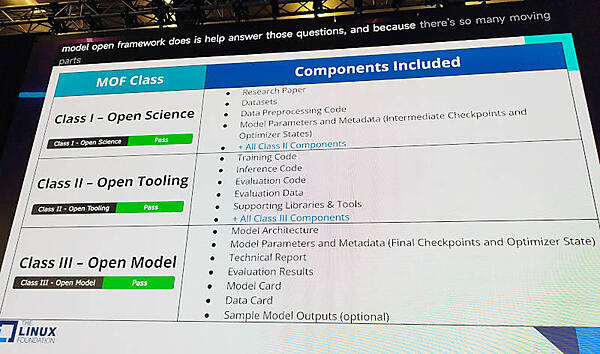

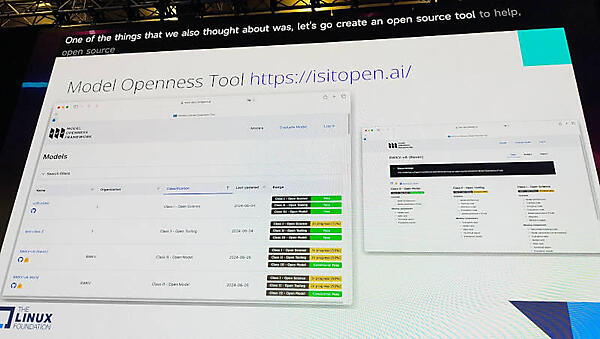

また大規模言語モデルについてはAI_devでも繰り返し強調されたModel Openness Framework(MOF)を説明。MOFはLLMのコンポーネントごとにオープンかどうかを判断する精細な基準を整理した仕様とツールで構成されており、すでに多くのモデルがそのオープンの度合いを審査されている。

●参考:Model Openness Framework(MOF)

この公式サイトのURLが「Is it Open?」という英文になっている点からも、生成型AIがオープンであるかどうかを意識していることを示していると言えるだろう。また説明の中で、生成型AIがオープンかどうかの定義をOSIが作成したというニュースも紹介し、Jim Zemlin氏が常に強調する業界標準、国際標準と足並みを揃えることの重要性を強調した形になった。ちなみにOSIが定めたという生成型AIのオープンの定義はLF/LF AIが作成したこのMOFを流用しているものであり、ここではLF/LF AIがISOをリードする形で標準化が進んでいることを示している。この辺りの経緯については以下のOSIの解説を参照されたい。

AI_devでも説明されたMOFの3つの段階を簡単に紹介。モデルがオープンかどうかを判断するのがクラス3、生成や利用のためのツールがオープンかどうかを判断するのがクラス2、そのテクノロジーを支える論文や最適化のためのパラメーターまでオープンになっているかどうか、つまりサイエンスとして評価できるレベルまで情報が公開されているかを判断するのがクラス1という分類だ。

最新のテクノロジーが日進月歩で登場する生成型AIにおいて、ツールや仕様を作成して公開したとしてもその追従は辛い仕事になるだろう。しかしオープンであることが最良の選択肢であることを疑わないLFの姿勢がここでも現れていると言えるだろう。

最後に2024年の重要なカンファレンスとしてAI_dev、KubeCon NA 2024そしてPyTorch Conferenceを再度紹介してキーノートを終えた。

全般的に中国及び香港からの参加者にLFのエコシステムの優秀さを訴求し、仲間になって欲しい、クローズドな生成型AIではなくオープンな生成型AIに向かって欲しいという願いが現れた内容となった。