Red Hatの年次カンファレンスRed Hat Summit 2024では、生成型AIが中心的なトピックとして何度も繰り返し語られた。これまではインフラストラクチャーの会社と見られていたRed Hatに取ってみれば大きな転換点と言えるだろう。この記事では、今回発表されたInstructLabを解説したセッションとメディア向けブリーフィングの内容から、Red HatのAI戦略を読み解いてみる。

最初に紹介するのは今回のサミットで発表された内容を振り返るメディア向けのブリーフィングだ。

登壇したのはキーノートでもお馴染み、製品担当SVPのAshesh Badani氏とCTOのChris Wright氏だ。

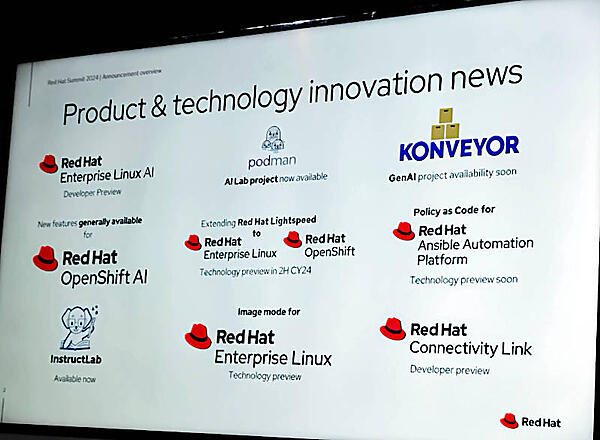

今回発表された内容を、製品とテクノロジーというカットで並べたのがこのスライドだ。

プレビューとして言わばベータ版としてのリリースとなったのが、Red Hat Enterprise Linux AI、Image Mode for Red Hat Enterprise Linux、Policy as a Code for Red Hat Ansible、Red Hat Connectivity Linkだ。またKonveyorについては、GenAI ProjectがAvailable Soonという表記になっている。デベロッパープレビューとテクノロジープレビューという2種類があるが、どちらも顧客向けに提供する前の段階のベータ版という認識で十分だろう。

この中で注目したいのは「~~AI」という製品と「~~Lightspeed」の違いだ。キーノートの中でもRHEL AIとOpenShift AI、そしてRHEL LightspeedとOpenShift Lightspeedが存在していた。Lightspeedが初めて導入されたのはAnsible Lightspeedだが、その後、RHELとOpenShiftにも使われるようになった。AnsibleについてはAIという名称が付く製品はなく、AnsibleとAnsible Lightspeedという2つになる。なおAnsibleにはコミュニティ版のAWXと、Red Hatが長期サポートを提供するAnsible Towerが存在するが、コミュニティ版については後述したいと思う。

「~~AI」については公開されたブログなどを参考にしてまとめることができる。

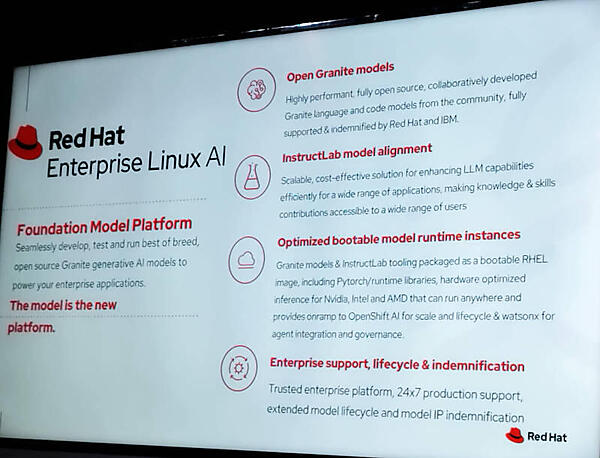

- Red Hat Enterprise Linux AI

PyTorch、Granite ModelとInstructLabのツールが追加され、イメージモードでコンテナイメージのままブートできるようになった製品 - Red Hat OpenShift AI

以前のOpenShift Data Scienceの名称が変更されたもの。JupyterLabのツールが有効化され、3rdパーティの機械学習ツールを追加できる設定が行われた製品

そしてRed Hat Enterprise Linux Lightspeed及びRed Hat OpenShift Lightspeedは、それらのプラットフォーム上で提供されるAIを応用した機能の名称ということになる。実際にメディア向けブリーフィングでの質疑応答では、Badani氏が「Lightspeedはそれ単体では切り離せない」という意味の回答を行っているように、プラットフォーム製品のコアに含まれる知的な支援機能ということになるのだろう。

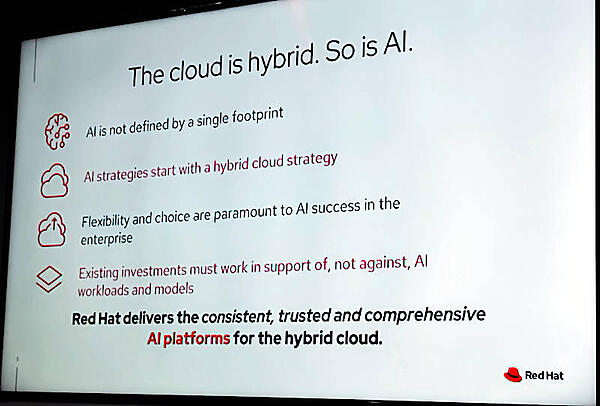

このスライドではオンプレミス、パブリッククラウドを問わずハイブリッドで実装することを推進しているRed Hatらしく、生成型AIについても顧客のニーズに従ってどのような形態でもAIを実行できなければいけないというメッセージを伝えている。

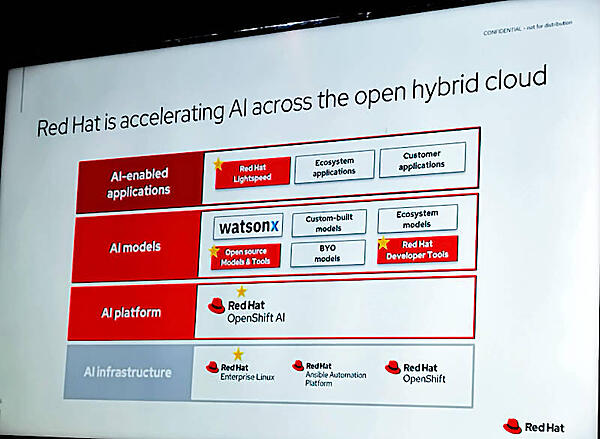

このスライドではLightspeedとAIの違いについて図式化されている。LightspeedはAIによるアプリケーション、AIは生成型AIに最適なプラットフォームを指すということが明記されている。またAI Modelという部分にはIBMのWatsonxだけではなく他のモデルも実装可能で、顧客に選択の余地を与えているということだろう。

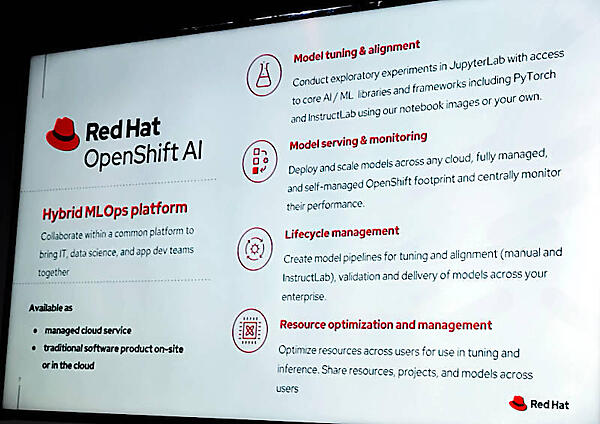

OpenShift AIについてのスライドでは追加されるツール群だけではなくモデルの開発と実装のライフサイクルにもポイントが置かれており、マニュアルで実施するのか、コミュニティが参加するオープンなInstructLab形式で行うのかを選択できるという。

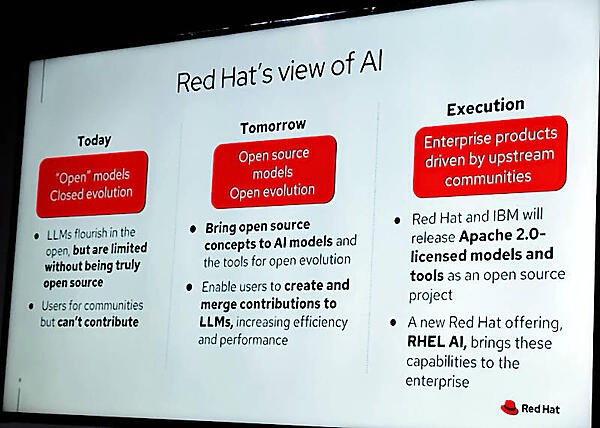

ここでIBMのGranite Modelをオープンソース化した背景が説明されている。Red Hatは現在の生成型AIがある程度はオープンだがモデルを進化、拡張させる部分についてはベンダーがクローズドに行っていることを問題視していると言える。

RHEL AIについてのスライドでは新しいプラットフォームであり、IBMのコード生成モデルであるGranite Modelが追加されること、InstructLabによってクローズドではないコミュニティ、ユーザーによるモデルの進化拡張が可能であることが示されている。イメージモードが生成型AIにどう関わってくるのかについては、ハイブリッドクラウドでのモデル実装のためには必須の機能という意図だろう。

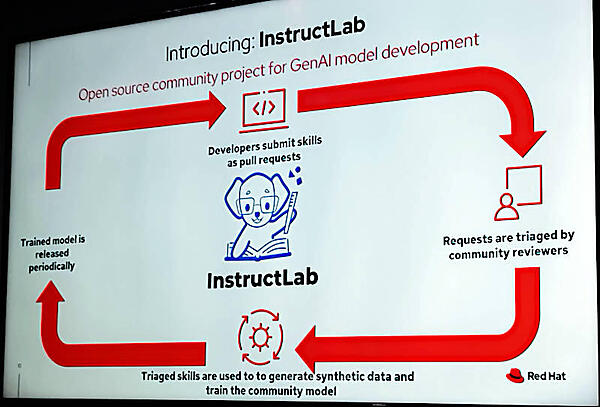

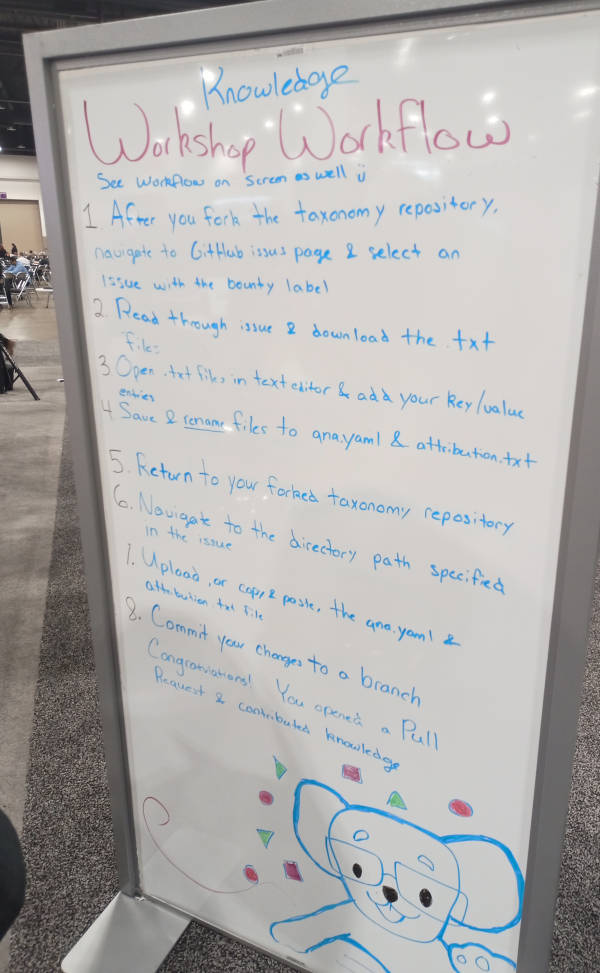

「オープンなモデル開発をどうやって行うのか?」という問いに対する回答がInstructLabだ。明確に「生成型AIのモデル開発を行うためのオープンソースコミュニティプロジェクト」であると記載されている。カンファレンスの展示会場であるExpoではInstructLabのブースが設置されており、参加者が実際にモデルに対して更新を行うことを体験できるようになっていた。

このスライドではデベロッパーがスキルをモデルにプルリクエストの形で提供し、それをレビューワーが承認することでモデルのアップデートが行われ、実装されるということが簡潔に書かれているが、実際にラボのブースに置かれていた手書きの利用方法では詳しくその操作手順が説明されている。タクソノミーのリポジトリーをフォークし、そこに含まれるイシューを選んでテキストエディターで修正を行い、コミットをするというソフトウェア開発に近い形に寄せているのがわかる。

ここまでで製品の位置付けとInstructLabの具体的な方法はある程度理解できたと思われる。次は「どうしてオープンな形でモデル開発を行わなければいけないのか?」の説明である。「The Role of open source in the age of AI」というセッションを紹介しよう。

プレゼンターはRed HatのDistinguished EngineerのJeremy Eder氏とIBMのHead of AI Open Innovation and the AI AllianceのAnthony Annunziata氏だ。

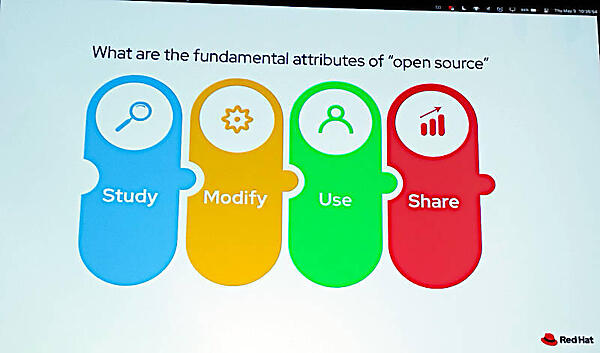

Eder氏は、オープンソースの原則をStudy/Modify/Use/Shareすることにあると説明。

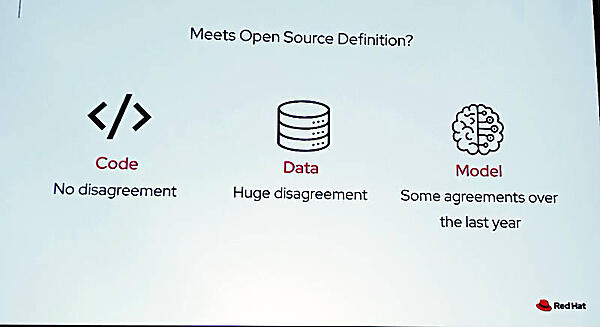

その原則を生成型AIに適用して判断するとすれば、処理を行うコード、処理の対象となるデータ、結果として得られるモデルについてはオープンソースの原則に沿ってコードは公開されているが、データは非公開、モデル自体についてもいくつかのベンダーや組織においては、同意は取れているが全体としてはオープンではないというのが現状認識だ。

そしてオープンソースとして成功しているプロジェクトとオープンな大規模言語モデルを比較するスライドでは頻繁なコードの更新、ロードマップが公開されていること、コミュニティからの貢献が継続していること、だれでもコントリビュータとしてコードの変更をリクエストできることなどを挙げた。しかし同時に、それを採用する大規模言語モデルがないことも挙げた。ここで唯一、置かれているのはInstructLabのキャラクターの犬のロゴだ。

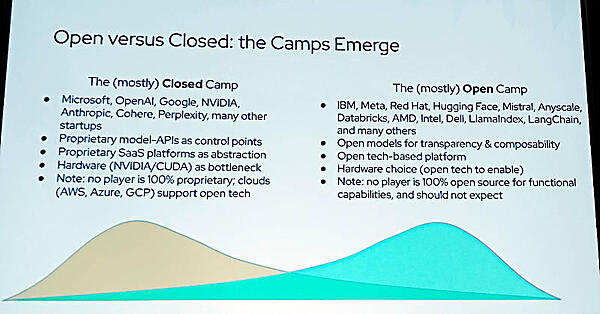

より具体的に「誰がオープンで誰がオープンでないのか?」というスライドでは、Microsoft、OpenAI、Google、NVIDIAなどの名前をクローズド側として挙げており、明確に違いを見せていることに注目するべきだろう。これに対してオープンな陣営にはMeta、Red Hat、Hugging Face、Mistral、AMD、Intelなどが挙げられている。但し書きとしてクローズドな陣営にもオープンソースプロジェクトをサポートしている組織は存在するし、オープンな陣営にもすべてをオープンにしているわけでもなくそうすることを期待するのも間違っているという文章が書かれている。

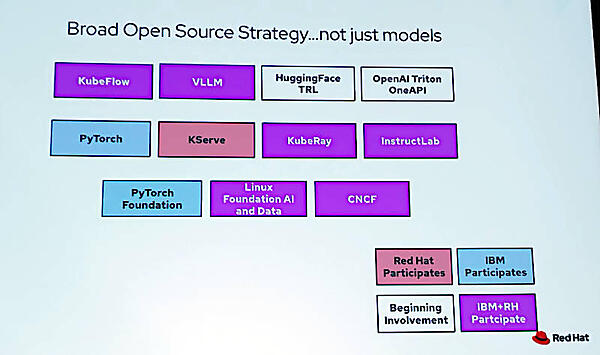

IBMとRed Hatが参加しているオープンソースプロジェクトについても簡単に説明し、IBMもRed Hatもそれぞれの思惑を持ちつつもオープンな原則に沿って生成型AIの開発のためのプロジェクトを推進したい、コミュニティの賛同を得たいという期待が現れていると言える。

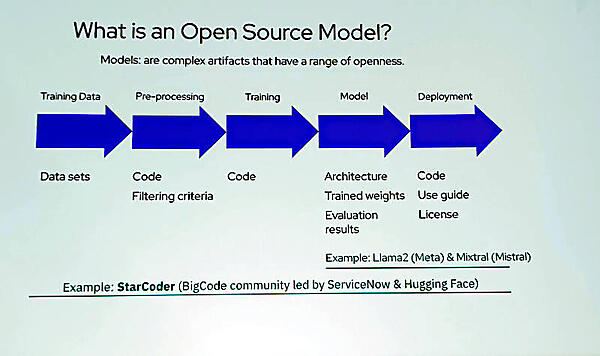

ここではモデル開発の段階においてどこまでがオープンなのかを説明。コード開発のための大規模言語モデルStarCoderというプロジェクトでは、データセットの段階からオープンになっているが、MetaのLlama2ではモデルの部分のみがオープンになっているという。

●参考:StarCoder: A State-of-the-Art LLM for Code

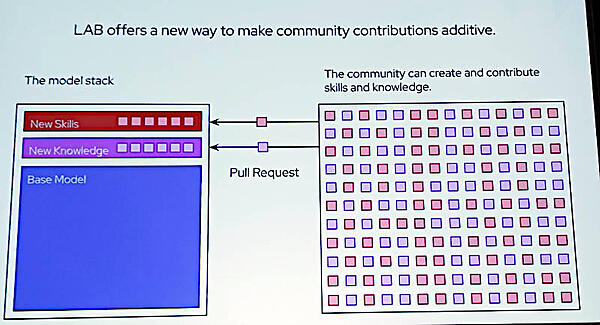

そしてInstructLabにおけるコミュニティからの貢献という部分では、InstructLabの概念が図式で解説されている。

ここではベースのモデルに対して追加する知識やスキルをコミュニティが作成して、それをプルリクエストでコミットする形で前出の手書きの利用方法の概念図とも言える。

IBMとMetaが提唱したThe AI Allianceについても簡単に説明し、オープンな環境で生成型AIを開発するための産学連携の組織として活動が始まっていると語った。

最後に予言としてLLMは今の熱狂的な興奮状態が落ち着いてくれば別のプログラミングモデルと見做されるだろう、対話型のAI実装は現行のSiriやAlexaなどのボイスアシスタントのレベルになってくるだろう、生成型AIモデルに対する検証や評価のためのツールには大きな投資が行われるだろうというコメントを紹介してセッションを終えた。

全体としてRed HatとIBMはオープンなコミュニティにおける大規模言語モデルの開発にこそ未来があるし、そこについて現在、クローズドで開発を行っているMicrosoftやGoogleが賛同して欲しいという意図を強く感じる内容となった。しかしRed Hatはすべての製品に対して先進的な機能をコミュニティと一緒に開発を行うアップストリーム版、その安定版であるエンタープライズ版、具体的に言えばLong Term Support版として提供するという原則を堅持している稀な企業だ。Ansible Lightspeedの部分でも書いたが、知的な機能の総称であるLightspeedについてはどのようなスタンスで望むのだろうか。文脈から読み取れば、Lightspeedはエンタープライズ版のみに提供ということになるのかもしれないが、コミュニティとの協調という意味ではコミュニティ版にも先進的な機能として提供されることを願いたい。

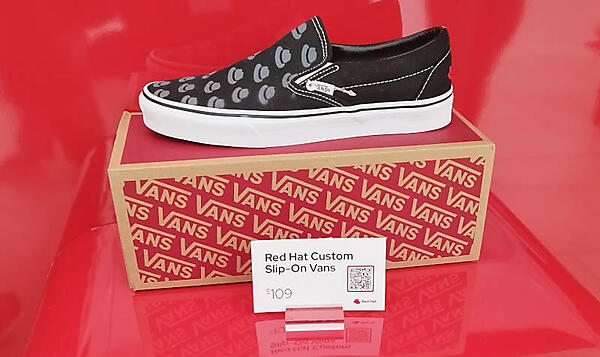

最後に冒頭で紹介したメディア向けブリーフィングで登壇したAshesh Badani氏とChris Wright氏が履いていたスニーカーは会場の公式ショップで販売されていたVANSの製品で、レッドハットのロゴである帽子のシルエットがプリントされているものだ。

- この記事のキーワード