はじめに

前回は、ガートナー社が発表している「ハイプ・サイクル」を題材に、AI関連技術が今、どのような状況なのかを紹介しました。ハイプ・サイクル上にいろいろなAI技術が乗っかっていましたが、1つ1つが何なのかを知らずに流すのはちょっともったいないです。そこで、今回からは、これらの技術を取り上げて解説していきます。

ただし、これらの技術を断片的に解説するのではなく、その技術が注目されている背景や関連技術も説明し、AIや機械学習の概要を把握してもらいます。まだ、AIについてよくわかっていない人も、この機会にAIのキホンを理解しましょう。

ハイプ・サイクルに登場する主な技術

それでは、早速ハイプ・サイクルに登場する技術を順番に解説していきましょう。まずはAIのキホンを理解するために2017年、2018年の黎明期に登場した技術からです。

(1)AI PaaSとエッジAI(2018黎明期)

2017のハイプ・サイクルにエッジコンピューティングが登場しましたが、2018年にはAI PaaSとエッジAIがそろって黎明期に入っています。これらの技術については、AIの提供形態の変遷の中で理解することにしましょう。

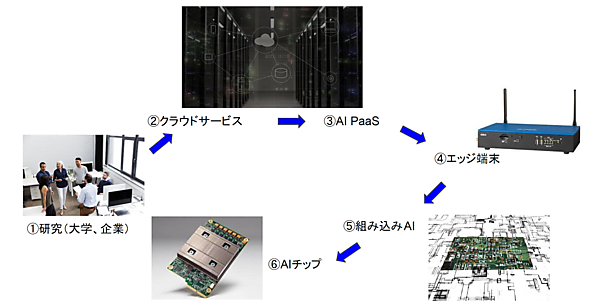

図1は、AIの提供形態が多様化していることを表したものです。今回は、①研究室から②のクラウドサービスを経て③AI PaaSというサービス形態が確立したところまで説明します。AIが社会に浸透するにつれて注目されるようになった④エッジ端末から⑤組み込み型AI、⑥AIチップに関しては次回に解説します。

図1:AIの提供形態の多様化 (画像出典 エッジ端末:OKI)

①研究(大学、企業)

今回のAIブーム(第3次AIブーム)は、最初は大学や企業の研究部門が主役でした。2012年にトロント大学がディープラーニングを使って画像認識コンテスト(ILSVRC)で圧勝すれば、モントリオール大学がAIライブラリTheano(テアノ)を開発、翌年にはバークレー大学が画像認識用ライブラリCaffe(カフェ)を開発という具合に、技術革新が一気に進みました。

ILSVRCは「ImageNet Large Scale Visual Recognition Challenge」の略で、画像認識技術の進歩を促すという目的で行われた世界的な画像認識コンテストです。2010年から始まったのですが、2012年にディープラーニング技術が1位を取ってからはディープラーニング技術同士の戦いになっていきました。毎年、ディープラーニングの階層が深くなったライブラリがチャンピオンを取るようになり、もう役目は終わったということで2017年を最後に終了しています。

企業も、大学教授をスカウトするなどしながら本格参入してきました。トップはGoogleで、2012年に教師なし学習で猫を認識できるAIを発表したのち、2015年にはAIライブラリTensorFlow(テンソーフロー)を公開し、これが現在一番シェアの高いライブラリになっています。このころはライブラリ競争が激しく、FacebookがTorch(トーチ)、日本のPreferred NetworksがChainer(チェイナー)、これらのラッパーとしてKeras(ケラス)などが次々と公開されました。続いてMicrosoftがCognitive Toolkit(CNTK)、FacebookがPytorch(パイトーチ)とCaffe2、中国の百度がPaddle Paddle(パドルパドル)、AmazonがMXNetというライブラリを公開しています。

「AIライブラリ」とは、ディープラーニングを行うために必要な機能を取り揃えたソフトウェアツールです。コンピュータに置き換えると、コンピュータを操作するさまざまな基本機能を持っているOSのような役目です。モデルや階層、重み、閾値、バイアスなどをパラメータ設定するだけで学習できる仕組みを持っているので、ユーザーはこれを使うことで、簡単にディープラーニングを学習できます。

②クラウドサービス

今回のAIブームは、ちょうどクラウド時代に花開いたことが特徴です。いろいろな分野でディープラーニングの成果が出てくると、大手クラウドベンダー各社はクラウドに機械学習環境(プラットフォーム)を提供するようになりました。

まず、2015年にMicrosoftがMicrosoft Azure Machine Learning、AmazonがAmazon Machine Learningというクラウド上で機械学習を行う環境を提供しました。2016年にはGoogleもGoogle Cloud Machine Learningを発表し、OracleはIntelligent Applications、SalesforceはEinsteinというクラウドのプラットフォームを発表しています。さらに2017年にはNVIDIAがNVIDIA GPU Cloud、テンセントが智能雲を発表しています。

同時に、これらのクラウドはAIライブラリで学習したAI(学習済モデル)をサービスとして提供するようになりました。その1つがGoogle翻訳です。かねてからGoogle翻訳は一定の評価を得ていましたが、2016年にGoogleがディープラーニング技術に切り換えたとたんに飛躍的に翻訳精度が向上して驚嘆されました。

③AI PaaS

AIサービスが増えるにつれ、単発ではなく総合的なAIプラットホーム(AI PaaS)としてサービス提供するようになりました。これはAIサービスだけというよりも、クラウドサービスの中にAI関連のサービスが増えていった結果、1ジャンルとしてAI関連サービス群ができた形態です。

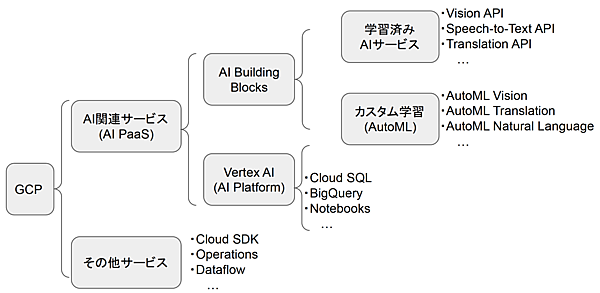

例えば、Google Cloud Platform(GCP)には、Cloud SQL(データベース)やBigQuery(データウェアハウス)、Dataflow(ストリーム処理)など100以上のサービスがあります。この中からAIや機械学習に関連したものだけをピックアップし、それをAI Building BlocksとVertex AI(旧AI Platform)に分類し、さらにAI Building Blocksを学習済AIサービスとカスタム学習(AUTOML)に分けています(図2)。

表1に現在(執筆時点)のAI Building Blocksの各サービスを示します。学習済みAIサービスはAPIの形式で提供され、ユーザーはこれらのAPIから画像認識や翻訳などのサービスをそのまま利用します。3年前にビジネスに活用するためのAIを学ぶを執筆した際はこのようなサービス提供が主流だったのですが、現在ではユーザーが用途に合わせて学習できる仕組みを提供するAutoML(カスタム機械学習)サービスが拡充されてきました。

表1:AI Building Blocksのサービス

[注]α、βはアルファ版、ベータ版提供を示す

・Vision Intelligence API(動画処理・分析)

| 1. 学習済みAIのサービス | |

| 画像/動画分析 | |

| 音声認識/音声合成 | ・Cloud Speech-to-Text API(音声認識と音声文字変換) ・Cloud Text-to-Speech(音声合成) |

| 機械翻訳 | ・Translation API(機械翻訳) ・Media Translation API(ファイルやストリームの翻訳)β |

| 自然言語処理 | ・Natural Language API(自然言語処理) ・Natural Language API(医療向け自然言語処理) ・Dialogflow(チャットBot作成) |

| 構造化データ | ・Cloud Inference API(時系列データの相関分析)α ・Recommendations AI(レコメンデーション) |

| 2. AutoML(カスタム機械学習) | |

| 画像/動画分析 | ・AutoML Vision(画像認識モデルをトレーニング) ・AutoML Vision Intelligence API(動画処理モデルをトレーニング)β |

| 機械翻訳 | ・AutoML Translation(翻訳モデルをトレーニング) |

| 自然言語処理 | ・AutoML Natural Language(言語処理モデルをトレーニング) |

| 構造化データ | ・AutoML Tables(表形式データからMLモデルを自動的に構築)β |

一方、Vertex AIは、さらに本格的にトレーニングするために必要なリソースを取り揃えた学習環境です。もともとはAI Platformという名前で提供されていたのですが、2021年5月に新しい機械学習プラットフォームとしてVertex AIを発表し、AI Platformはその中に組み込まれる形となりました。

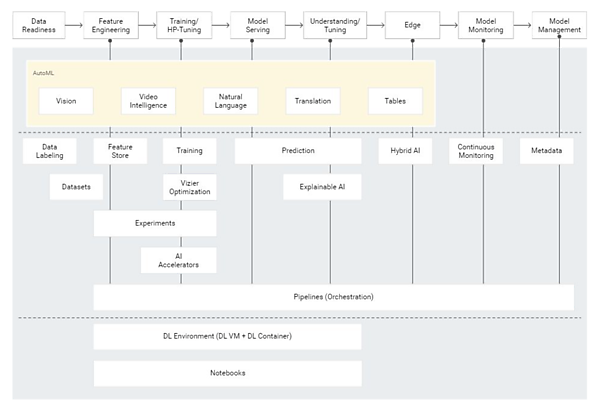

Vertex AIは、AIモデルの作成作業をData Readiness(データの準備)からModel Management(AIモデル管理)までのユースケースに整理して、各プロセスにおいて必要となるAIサービスを総合的に提供します(図3、表2)。

図3:Vertex (出典:GoogleのHP)

表2:Vertex AIのユースケースとサービス内容

| ユースケース | サービス |

| Data Reedinessデータの準備 | BigQueryやCloud Storageからデータを取り込み、Data Labelingを活用してアノテーション(ラベル付け)を行えます。 |

| Feature Engineering特徴量エンジニアリング | Feature Engineering(特徴量エンジニアリング)とは、データから機械学習モデルに役立つ変数(特徴量)を作成する作業のこと。Feature Storeは、その作業に必要な機能を提供するリポジトリで、Experimentsを使って効率的にモデルの選択を行えます。 |

| Training/HP-Tuningトレーニングとハイパーパラメータ調整 | Notebooksは、Pythonなどの言語を使ってAIモデルを構築できる総合開発環境。Trainingを使ってAIモデルのトレーニングを行う際に、Vizierを利用してハイパーパラメータを最適化します。 |

| Model Servingモデルの提供 | Predictionを使用すると、HTTP経由でオンライン サービス提供したり、AIモデルを本番環境にデプロイできます。 |

| Understanding/Tuningモデルの調整と理解 | Explainable AI(説明可能なAI)は、AIモデルがどうしてその結論を出したかを理解するためのサービスで、各特徴量が予測にとってどの程度重要としたかを見える化できます。 |

| Edgeエッジ | Edge Managerは、トレーニング済のAIモデルをエッジコンピュータにデプロイしたり、監視したりできるAPIを用意しています。 |

| Model Monitoringモデルのモニタリング | デプロイされたAIモデルは、継続的にモニタリングされ、アラートや偏差の原因診断、トレーニング データの収集などが行えます。 |

| Model Managementモデルの管理 | Pipelines は、機械学習ワークフローを管理するためのツール。Metadataを使用すると、Pipelines内のすべてのコンポーネントの入出力が追跡され、監査とガバナンスが容易になります。 |

おわりに

今回は、Google Cloud Platformを題材に、AI PaaSでどのようなAIサービスを提供しているかをイメージしてもらいました。3年前は画像認識や自然言語処理など用途別の学習済モデルの提供が中心でしたが、AIをお試しではなく、本格的に利用するためにはユーザー自身が目的に合わせて学習する必要があります。そうしたニーズに対応して、ユーザーが簡単に機械学習できるAutoMLが、まだβ版が多いもののラインナップされてきています。

一方で、AutoMLは未だ進化の途中であるため、ユーザーはやはりAIライブラリを使って自身で機械学習してモデルを作成する必要があります。そのための環境を体系的にまとめたVertex AIにより、ユーザーは高度なAIモデルを効率的にトレーニングしてデプロイできるようになりました。

さて、このように学習環境も充実してきたわけですが、学習されたAIがどのような形で社会に利用・浸透されつつあるのか、次回のエッジ、組込みAI、AIチップでそのあたりを解説します。