クラウドネイティブなオープンソースソフトウェアをテーマにした世界最大規模のソフトウェアカンファレンスKubeCon+CloudNativeCon Europe 2024が、2024年3月19日から22日までパリで開催された。

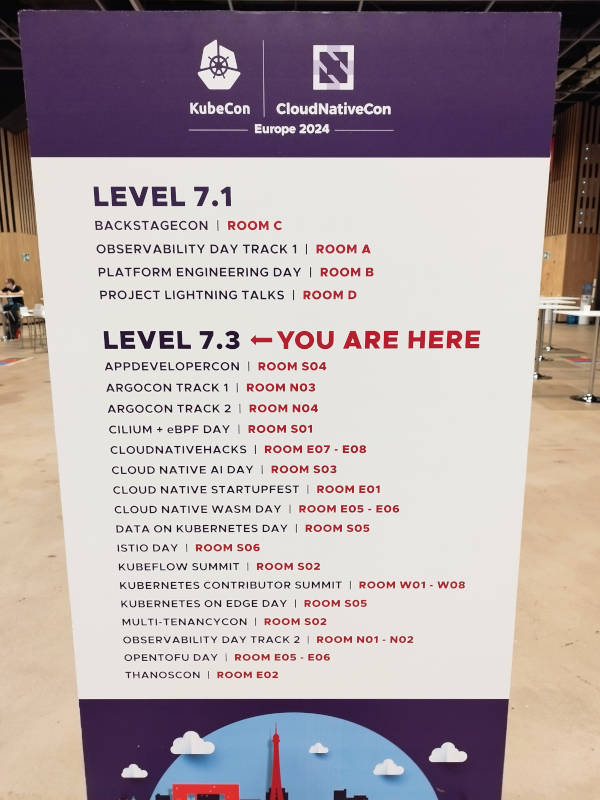

KubeCon Europe自体の3日間の会期に加えて、前日にはCo-located Eventとして多くのミニカンファレンスが開催された。

このボードに書かれている共催イベントのリストから、その多様さを感じられるだろう。CNCFがホストするいくつかのプロジェクトに特化したミニカンファレンスに加えて、AIやWebAssemblyなどのテクノロジーやCNCFのプロジェクトに貢献しているコントリビューターのためのサミットなどが開催された。今回は過去最高の参加者数になるという告知が事前にされていたが、この日も多くの参加者が会場に集い、過去の共催イベントとは桁違いの参加者数となることが感じられた。その中から今回はCloud Native AI Dayのようすを紹介する。今回取り上げるのは午前中に行われたCERNの事例に関するセッションと、Red HatのOpenShift AIのマーケティング担当が解説する医療機関における事例のセッションだ。

CERNでの事例

最初のセッションは「Training & Optimisation of Large Transformer Models: ALTAS and CERN Use Case」、プレゼンテーションを行ったのはCERNのインフラストラクチャー担当であるRicardo Rocha氏とCERNのインフラストラクチャーを使って行われている研究のひとつATLASの概要を解説するオックスフォード大学の素粒子物理学者Maxence Draguet氏だ。

CERNについて

Rocha氏は最初にCERNの概略を紹介し、そのコアであるLHC(Large Hadron Collider、大型ハドロン衝突加速器)については動画を用いて仕組みを示した。素粒子を光速に近い速度に加速し衝突させ、その反応を調べる世界最大の実験装置であるLHCでは短時間に大量のデータが採取され、その後スーパーコンピュータによって処理されるというのが概要だ。ちなみにLHCは円周の長さが27kmにも達し、これは山手線とほぼ同じ長さに相当し、地下100メートルに設置してあるという。

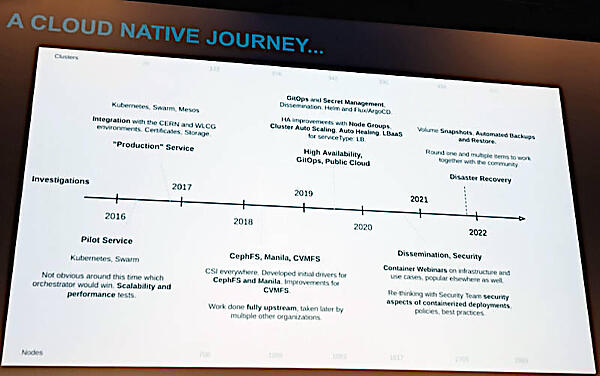

Rocha氏はクラウドネイティブなソフトウェアをCERNがどのように使ってきたのか? について、線表を使って解説。実際にはカスタムメイドのハードウェアとソフトウェアによってHPCを実装してきたが、先端的なテクノロジーが商用CPUとGPUの利用に移行していった流れに沿って、Off the Shelf(既製品)のコンポーネントを使うようになってきたと説明。それと同時にKubernetesやSwarmなどのオーケストレーターの検証を始めたという。2016年から始まったという線表だが、CERNはOpenStackのユーザーとしても知られており、さまざまなプラットフォームを検証し利用していることがわかる。

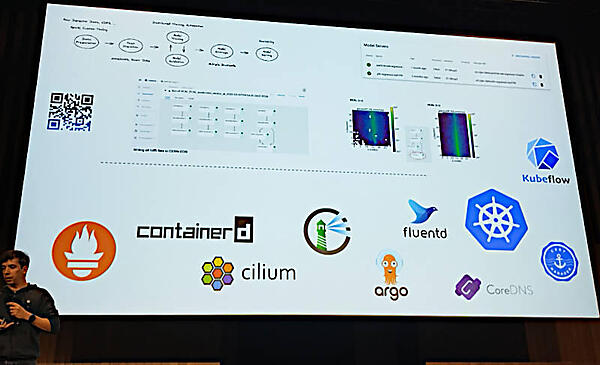

その中で特にこのセッションでは、CERNのHPCにおけるワークフローの中心となっているKubeflowについて解説を行った。

ここではKubernetesやPrometheus、Cilium、ArgoCD、Fluentdなどのロゴが確認できる。そしてCERNの持つ課題としてHPCにおける電力消費と発熱、ハードウェアの進化のスピード、CPU/GPUとストレージのインターコネクトなどについて触れ、それらを満足させるためのソリューションが必要になっていると解説した。

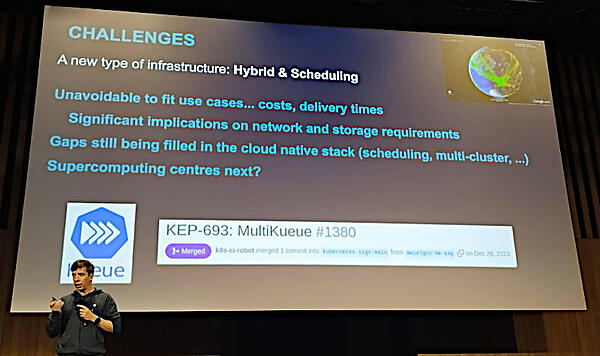

その中でKubernetesにおけるジョブのスケジューリングを実装するKueueについても簡単に触れ、HPCが要求するバッチジョブをKubernetes側から制御したいというCERNの要望が実現したことを説明した。

●参考:https://github.com/kubernetes-sigs/kueue

KueueはKubernetesのSIGの中で始まったサブプロジェクトで、Kubeflowとも連係することでHPCに必要なバッチ型のワークロードを実行できるようにすることが目的だ。

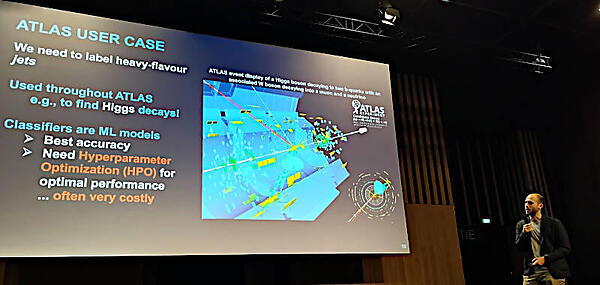

ATLASについて

そして後半はバトンタッチしたDraguet氏がATLASについて解説を行った。

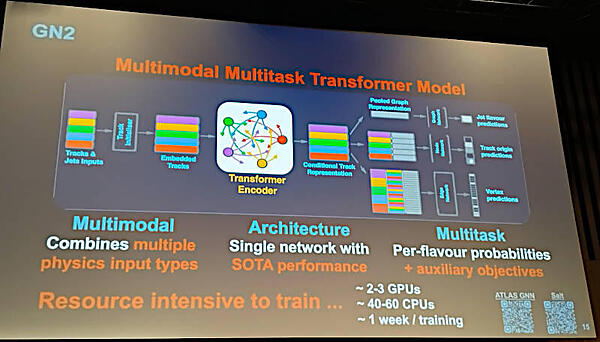

ATLASはさまざまな形式のデータを変換する多層のモデルの実装型であり、モデルの学習のためには複数のGPUと大量のマルチタスクによるCPUタイム、具体的には1週間程度の実行時間が必要という大きなシステムである。

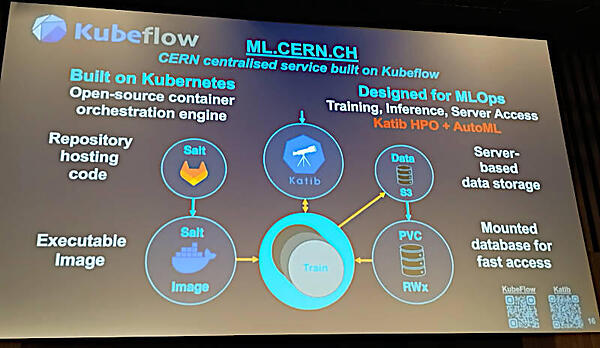

KubeflowがCERNの機械学習のコアのプラットフォームとなっているとして、その概要を解説。

Kubeflowは機械学習のワークロードをKubernetes上でスムーズに実装するためのツール群で、Pipeline、Notebook、Dashboard、AutoMLなどから構成されている。

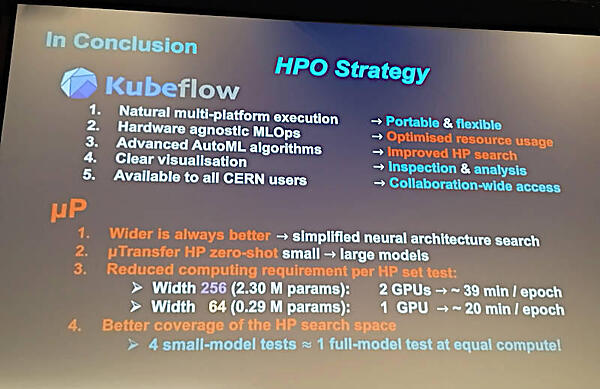

ここからはハイパーパラメータの最適化の解説が主に行われ、数式に馴染みがない参加者(筆者を含む)にとっては辛い時間となったが、さまざまなパターンについてデータを採取して比較検討する姿勢はまさに研究者であり、それはKubeflowのセッティングにおいても変わらないことは理解できた。

ハードウェアに依存しない機械学習の運用パターンが可能という点は、オンプレミスとクラウドサービスを使いこなしたい企業においては参考になるかもしれない。

セッションの動画は以下から参照して欲しい。

●動画:Training and Optimisation of Large Transformer Models: An ATLAS and CERN Use Case

- この記事のキーワード