はじめに

今回は、2023年11月7日に開催された「OpenAI DevDay」で発表された中から「GPT-4 Turbo」と「AIアシスタント」を中心に解説します。2022年11月にChatGPTが公開されて1年が経過しましたが、まだまだ進化が続いていて、この先、どんなに便利になってゆくか楽しみです。

GPTシリーズのラインナップ

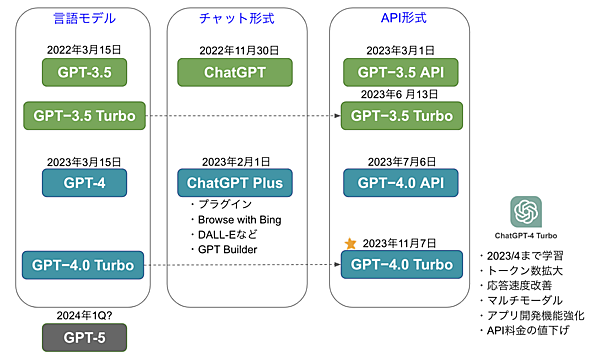

OpenAIが新しくリリースしたGPT-4 Turboは、これまでのGPT-4 APIを進化させたもので、2023年4月までのデータで学習している、プロンプトのトークン数制限を大幅に拡大している、画像などのマルチモーダル対応、API料金の大幅値下げなど、かなり嬉しい内容になっています。ラインナップが増えて来たので言語モデルとチャット、APIに分類して図1にまとめました。まずはこの図を使って相関関係を説明します。

言語モデル

言語モデルとして現在リリースされているのはGPT-3.5とそれを進化させたGPT-4です。それぞれを拡張したものがGPT-3.5 TurboとGPT-4.0 Turboですが、これらは現在のところAPIでのみ利用できます。来年1クォータに次世代のGPT−5が出るのではと言われていますが、これは今のところ噂レベルの話です。

チャット

言語モデルの利用方法には、ユーザーがブラウザを使って利用するチャット形式とシステムがAPIを使って利用するAPI形式があります。GPT-3.5をベースにチャット形式で世の中に公開した最初のモデルが2022年11月にリリースされたChatGPTです。無料で公開されていることもあって、これが今回の生成AIブームの火付け役となりました。

GPT-4をベースに今年2月にリリースされたのがChatGPT Plusで、こちらは月20ドルの有料版です。私も利用しているのですが、ChatGPT3.5と比べて格段に優れており、ビジネスで使うならもうChatGPT3.5には戻れないです(月20ドルはそれなりの出費ですが)。現在、ChatGPT Plusは言語モデルとしてGPT-3.5とGPT-4.0を選択できるようになっていますが、3.5を選ぶ人はいないでしょう。ここにGPT4.0 Turboも追加されると言われていますが、そうなると嬉しいですね。

API形式

システムが生成AIを利用するためにはAPI(Application Programming Interface)を利用することになります。私の会社でもいろいろな製品・サービスでGPT API経由で生成AIを利用しています。APIはどれも有料でGPT-3.5ベースとGPT-4.0ベースがあるのですが、こちらも圧倒的に4.0のほうが優れており、利用するなら4.0一択だと思います。そこに登場したのがGPT-4.0 Turboで、私の会社でもさっそく利用していますが、これまでの制約が大幅に解消されて、かつ価格も安くなってとても評判が良いです。

GPT-4.0 Turbo

GPT-4.0 Turboがどのようなものか、もう少し詳しく見てみましょう。表はGPT-4.0 Turboを従来のGPT-4.0 APIと比較したものです。

表:GPT-4.0 TurboとGPT-4.0 APIの比較

| GPT-4.0 Turbo | GPT-4.0 API | |

|---|---|---|

| 学習データ | 2023年4月まで | 2021年9月まで |

| 入力できる文字数 | 128,000トークン | 32,768トークン |

| 応答速度 | 高速 | 普通 |

| マルチモーダル | テキスト 画像入力 画像出力 音声出力 音声入力(近日予定) | テキスト |

| アプリ開発強化 | Function Calling機能強化 コード表記の指定 モデル出力の一貫性 | Function Calling機能 コード表記の揺れ |

| 料金 | 入力:0.01ドル/1000トークン 出力:0.03ドル/1000トークン | 入力:0.03ドル/1000トークン 出力:0.06ドル/1000トークン |

学習データ

GPTシリーズの弱点は学習データが2021年9月までであり、最近の情報に疎いことでした。GPT-4.0 Turboは2023年4月までのデータで学習しているので、この課題はだいぶ解消されます。今回の11月7日リリースに対して4月までの学習データということですから、学習から公開されるまでの期間が半年程度かかる状況ですね。今後は、この間隔をもっと縮めて、更新頻度も高めてくれることを期待しています。

入力できる文字数

入力できる文字数が128,000トークンと拡張されました。GPT-4.0 APIを使っていたときは、大きなデータを読み込ませるのに分割するなど苦労していたのですが、約4倍に増えてかなり楽に作業できるようになりました。

トークンはNFT(非代替性トークン)や暗号通貨トークンなど幅広い使い方をされる言葉です。言語モデルにおいては、トークンは文字や単語の量を表す単位として使われます。英語の場合は単語単位で、1単語1トークンでカウントされます(カンマやピリオドも1トークン)。一方、日本語の場合は文字単位で、ひらがな1文字が1〜2トークン、漢字1文字が2〜3トークンです。例えば「あ」や「い」は1トークンですが、「ょ」や「ぱ」は2トークンになります。

例えば、1文字平均2トークンとすると、GPT-4 APIの上限は約16,000文字です。1ページ400字で計算すると40ページ相当ということになります。GPT-4.0 Turboのトークン数はこの4倍ですから、だいたい240ページくらいのドキュメントを読めることになります。

なお、トークン数はOpenAIが提供するトークナイザー(tokenizer)で確認できます。

応答速度

GPT-4.0 Turboは、GPT-4.0 APIより応答速度がかなり速くなっています。一度に扱えるトークン数が4倍になっていますが、処理速度が速くなっているので問題ないって感じです。

マルチモーダル

マルチモーダルとは、複数の異なるタイプの入力(モード)を処理することでしたね。チャット形態のChatGPT Plusはマルチモーダルでしたが、これまでAPIはテキストしか入出力できませんでした。そのため、画像や音声を扱う場合は、外側にテキスト・画像変換やテキスト・音声変換をかませる必要がありました。

GPT-4.0 Turboではテキストに加えて画像の入出力や音声出力などが直接可能になり、マルチモーダルなアプリケーションが作りやすくなりました。「GPT 4Turbo with vision」APIを利用して画像を入力したり、DALL E3が使える「Image API」により画像生成も行なえます。またTTS(Text to speech)による音声合成では6つの音声から好きな声色を選択できます。音声入力の方は「Whisper V3」という音声認識機能が近日中にサポートされる予定です。

マルチモーダルになると生成AIの利用の幅がぐっと広がります。例えば、ファッションを販売するeコマース事業者が洋服の画像をインプットしてAIに購買意欲を掻き立てられるような説明文を作成してもらったり、音声出力を使ってバーチャルアシスタントや朗読AIを作ったりすることも実現しやすくなります。ただし、画像の入出力や音声合成はデータサイズに応じて追加コストが発生しますのでご注意ください。

アプリ開発機能の強化

GPT-4.0 APIはFunction Callingという機能により、外部APIを呼び出して情報を取得して利用できます。これを使うことで、例えば天気予報APIを呼び出して天気情報を利用したり、外部の計算APIを呼び出して高度な統計処理を行ったりができます。

これまでは1回のCallで1つの関数を呼び出す方式でしたが、GPT-4.0 Turboでは1Callで複数の関数を呼び出して利用できるように改善されています。OpenAIの例示を引用すると「車の窓を開けてエアコンをオフにする」というような複数のアクションを1つのメッセージで送信できるようになったとのことです。

生成AIにコード生成を依頼したときに、生成されたコードの表記が揺れる問題も解消しました。例えば「JSON mode」と指定するとGPTモデルは有効なJSONコードを生成することが保証されます。また、新しいパラメータrespose_formatでフォーマットを指定して、生成されるXMLやJSONの形式を指定することもできます。さらにモデルが回答のたびに出力内容が変わってしまわないように、新しいパラメータseedを使って出力を再現可能にする機能も追加されています。

料金値下げ

APIは従量課金で、システムと連携して利用するため、利用コストを意識する必要があります。通常、実現したいアプリケーションでどのくらいトークンが発生するかシミュレーションしてコスト計算します。その上でアプリケーションのユーザーに利用制限を加えたり、利用量に応じた従量課金などの仕組みを考えるわけです。

今回、扱えるトークン数が増えたのに対応して、トークンの入力で1/3、出力で1/2の料金となりました。128,000トークンで240ページと仮定し、このドキュメントを読むケースでコスト計算してみましょう。1000トークンの入力で0.01ドルなので1.28ドル、レート150円で計算すると192円となります。

OpenAIのAPI

OpenAIのModelsというページでは、さまざまなAPIモデルが公開されてます。この中から今回のリリースに関連するAPIモデルをいくつか紹介しましょう。

gpt-4-1106-preview

上記で説明しているGPT-4 Turboのプレビュー版です。2023年までのデータで学習し、128kコンテキストウィンドウがあります。

gpt-4-vision-preview

gpt-4-1106-previewにvision(画像入力)機能が付いたモデルです。入力される画像サイズに応じて別途料金が発生します。また、画像出力の方は、チャット形式のChatGPT PlusやChatGPT Enterpriseで最近利用可能となっているDALL-E 3モデルを指定することで利用できます。こちらも生成される画像サイズに応じて別途課金されます。

dalle-e-3

DALL-E 3(ダリースリー)は、OpenAiによって開発された画像生成モデルです。テキストで指定した内容に基づいてアート作品を創作したり、広告素材をデザインしたり、イラストを生成したりできます。

ChatGPT PlusでもDALL-Eを使えるので、どのような画像を作成してくれるか試してみましょう。図2はChatGPT PlusのDALL-Eに「サンタクロースがソリに乗ってやってくるイラストを森と海と丘と高層ビルの4つ場所に分けて作ってください」と依頼して作成してもらった画像です(サービス精神旺盛なのか2枚ずつ作ってくれました)。チャットでやり取りできるので、作成してもらった画像にいろいろ注文を付けて自分の欲しい画像に調整して行けるのが便利なところです。

tts-1/tts-1-hd

TTS(Text to speech)は、テキストを音声に変換するAIモデルです。tts-1はリアルタイムの読み上げ向けに最適化された速度重視のモデルで、tts-1-hdは品質重視のモデルです。

アシスタントAPI

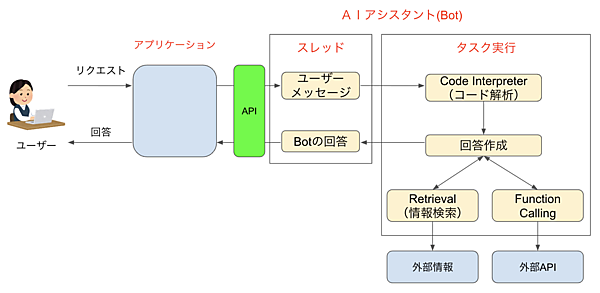

GPT APIを利用する目的の1つに、アプリケーションを利用するユーザーを支援するAIアシスタント機能を実装したいという用途があります。このニーズに応えてDevDayで発表されたモデルがアシスタントAPIです。これを利用することでアプリケーションの中にユーザー操作を支援するAIアシスタントを組み込むことができます。

図3はアシスタントAPIの仕組みを表したものです。アプリケーションを利用するユーザーからのリクエストは、アプリケーションからアシスタントAPIを経由してAIアシスタント(Bot)に伝えられます。

AIアシスタントは、この内容をCode Interpreterで解析し、必要に応じてRetrievalで外部情報を検索したり、Function Callingで外部APIを呼び出してベストと思われる回答を作成し、それをAPIを通してアプリケーションに返します。

ユーザーメッセージはテキストだけでなく、画像やファイルを含めることができます。メッセージや回答は保存され、適切な量で自動的に切り捨て処理されます。

ChatGPT Plusの機能強化

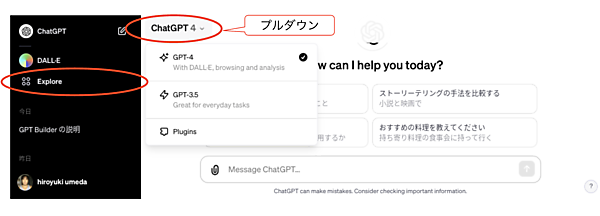

ChatGPT Plusの方もデザインが代わり、機能が拡充しました。

図4は、執筆時点の新しいデザインです(デザインはちょくちょく変わります)。左ペインにOpenAIの提供するアプリを一覧表示するExplorerが置かれ、その上に最近使ったアプリ、その下に投げたプロンプトの履歴が一覧表示されています。入力したプロンプトそのものではなく、要約して短くまとめているところがさすがだと思わせます(このGPT利用法は自分たちのアプリでも使えそうですね)。上部のプルダウンはGPT-4かGPT3.5かPluginsを選択するもので、図4はプルダウンを開いた状態のスクリーンコピーです。

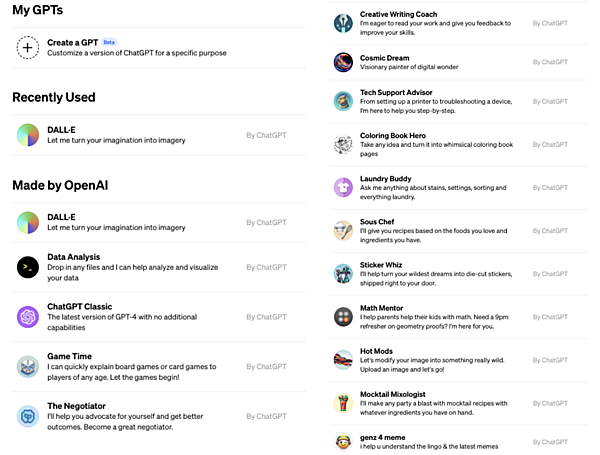

Explorerを開くと図5のような画面が表示され、「Made by OpenAI」としてOpenAIの提供する機能やアプリの一覧が表示されます(2列にしていますが、実際は縦1列表示)。ここに表示されているものは執筆時点のもので、今後、プラグインと同じように拡張されてゆくものと思います。

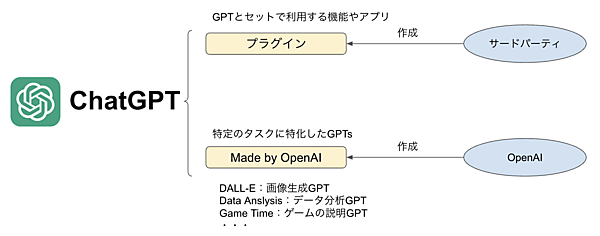

サードパーティが開発した「プラグイン」はOpenAIの提供するGPTと組み合わせて、より便利に使えるようにする機能やアプリでした。これに対し「Made by OpenAI」で提供されるGPTsは、OpenAIが特定の用途に向けて独自にカスタマイズしたGPT群です。

おわりに

今回は、以下のような内容について学習しました。

- OpenAIはGPT-4の進化版「GPT-4 Turbo」をリリースし、これはAPI経由で利用できる

- GPT-4 Turboは「速い」「安い」「うまい(アプリ機能強化)」に加えて「新鮮(学習データが2023年4月まで)」「ボリューム(トークンが4倍)」「多品目(マルチモーダル)」

- OpenAIの画像生成モデルDALL-E 3を使うと、いろいろな画像やイラストを作成できる

- アシスタントAPIを使ってAIアシスタントを作成することもできる

- ChatGPT Plusも機能拡張し、Made by OpenAIとしてさまざまなGPTsが利用できるようになった

次回は、新しくなったChatGPT Plusを中心に、Made by OpenAIとして利用可能となったGPTsの中から便利なものをいくつか紹介します。