Kongが開催したKong API Summit 2025から、Microsoftのエンジニア2名が解説を行ったKAITO(Kubernetes AI Toolchain Operator)のセッションを紹介する。このカンファレンスにおいてKongは「生成AI」という用語から離れて「エージェンティックAI(Agentic AI)」という用語に切り替えてその違いを訴求している。LLMとエージェントによる外部連携が可能になるのは、Anthropicが開発し公開したMCP(Model Context Protocol)が凄まじいスピードで業界に受け入れられているからだが、このセッションで解説されるKAITOはMCP登場以前に持て囃されたRAG(Retrieval-Augmented Generation)を、Kubernetes上に実装する際の仕組みをオペレータフレームワークに沿ってカスタムリソースなどを使ってコード化したものである。ここで言うRAGとは、生成AIがトークンを合成する前に製品マニュアルなどの静的なデータソースを利用することで回答の精度を上げる技術である。

プレゼンテーションを行ったのはMicrosoftの2名のエンジニアで、Sachi Desai氏はAzureのプロジェクトマネージャー、Steve Griffith氏はGlobal Black Beltというシニアな肩書を持つエンジニアだ。

KAITOはオペレータフレームワークとして実装されたソフトウェアで、実質的にはMicrosoftが開発を行い公開していると思って良いだろう。Cloud Native Computing Foundation(CNCF)のサンドボックスプロジェクトとしても採用されているが、パブリッククラウドへの対応はMicrosoftのAzure一択のようだ。LLMとして使えるモデルにはMicrosoftのphiの他にLlama3やgpt-oss、Alibabaが開発したqwen7b/32bなどもあげられている。

●参考:The current supported model families with preset configurations

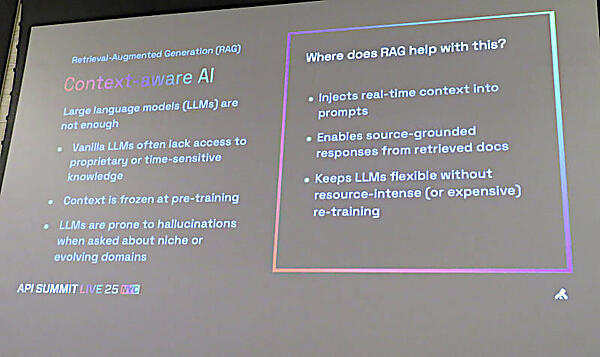

最初にRAGのコンセプトを紹介。ここではコンテキストを理解したAIを実装する手法であると説明されている。

ここでは過去の時点のデータで学習されたモデルに対して、より最新のデータをフィードする方法という側面と、そのアプリに必要なドメインの知識(データ)をフィードするという側面があると説明されている。どちらもハルシネーションを減らすための発想だ。

ここでRAGのプロセスを簡単に紹介。Retrieverがデータを取り込みベクターデータ化し、ベクター化された外部データとプロンプトからの入力をどう使うかをパイプラインのロジックに従って合成し、LLMへの入力としたうえでLLMからのトークン生成を結果として返すというものだ。推論のためのトラフィック管理とオブザーバビリティをパイプラインに対して行うという部分が強調されているのは、Kongのカンファレンスだからだろうか。

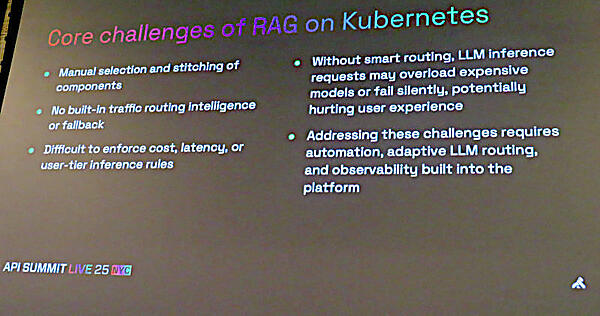

このスライドではRAGをKubernetes上に実装する際の課題について整理を行っている。すべてのコンポーネントをマニュアルで構成するのは非現実的と言える。効果的なトラフィック管理やオブザーバビリティの欠如といった点などを解消するために開発されたのが、KAITOということになる。

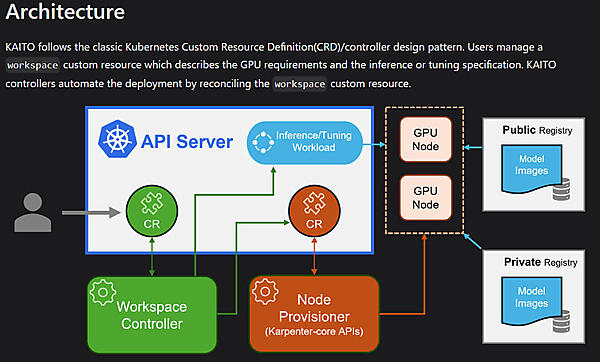

KAITOによってKubernetes上でRAGの実装が容易になると説明。KAITOについては公式のGitHubサイトが参考になるだろう。以下のアーキテクチャー図は公式サイトからの引用だ。

開発のスピードが速い生成AI界隈らしく、すでに0.5.0というバージョン以降ではコンポーネントに変化が起こっているようである。利用するモデルが要求するKAITOのバージョンも変っているため、コミュニティを注視しておく必要はあるだろう。

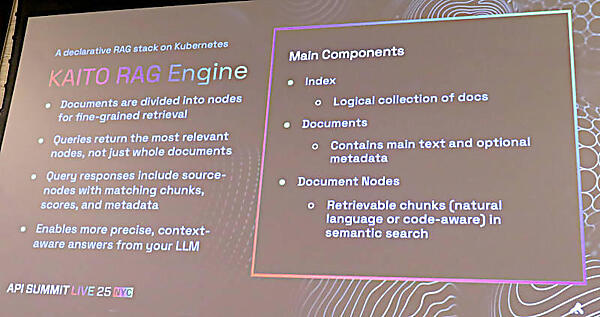

このスライドでは「KAITOがどのように外部のデータを利用するのか?」について解説している。外部から取り込まれたデータはdocumentsというデータセットとして利用され、ノードに分散されて実行されるようだ。そこからプロンプトに従って演算され、点数の高いベクターデータが結果として返されるという仕組みのようだ。

最後にまとめとして、RAGをKubernetes上で実装するツールとしてのKAITOを紹介。ここではLLMの演算の部分にはvLLMがランタイムとして利用され、トラフィック管理の部分にはKongのAI Gatewayがエッジにおいて利用可能であることが解説された。スライドの最後にKong AI Gatewayとの互換性は継続的に向上していく予定であることが小さく書かれていることから察すると、KAITO自体にはKong AI Gatewayは必須というわけではなく「エッジノードに使うことも可能である」という程度なのだろう。KongのカンファレンスでKAITOを解説するためには、Kongのプロダクトとの連携を(将来計画としてでも)書いておくというのがスポンサーとしての礼儀かもしれない。

ただしKong自体がすでにエージェンティックAIとしてMCPを前面に押し出している以上、KAITOもMCPを利用する前提で進化していくことが必要なのかもしれない。この辺りはコミュニティで大いに議論されていくことだろう。今後に注目していきたい。

●参考:KAITO公式ページ