OpenShift AIの事例

OpenShift AIの事例

次に紹介するのは2024年2月にRed HatのOpenShift AIのチームが来日した時にインタビューを行ったChristopher Nuland氏と、ELOTLのVP of EngineeringであるSelvi Kadirvel氏がKubernetesのマルチクラスターを管理するFleet Managerを使って実装した事例に関するセッションだ。

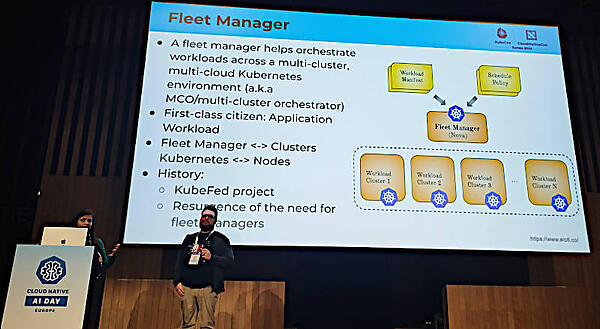

ちなみにFleet ManagerはAWSのシステム管理の機能としても知られているが、この場合はELOTLのマルチクラウド用コントロールプレーンであるNovaの機能を指している。

●参考:Nova: A Policy-Driven Multi-Cloud Multi-Cluster Orchestrator

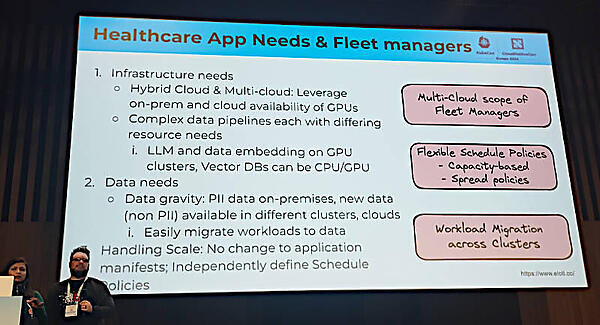

マルチクラウドを利用する上で一般的なWebアプリケーションではなく、機械学習に使われることを想定して大量のデータをオンプレミス、パブリッククラウドで使い分ける際にクラスターの選択をFleet Managerで行い、クラスター内のワークロードの管理はKubernetesに任せるという発想だろう。

その上で実装段階において必要な仕事とシステムが立ち上がった後で運用として必要な仕事について解説し、ワークロードの処理時間がWebアプリとは異なる性格を持つことを指摘。特にポイントとなるのが、ジョブに必要なリソースをどうやって確保するのか? だと説明した。

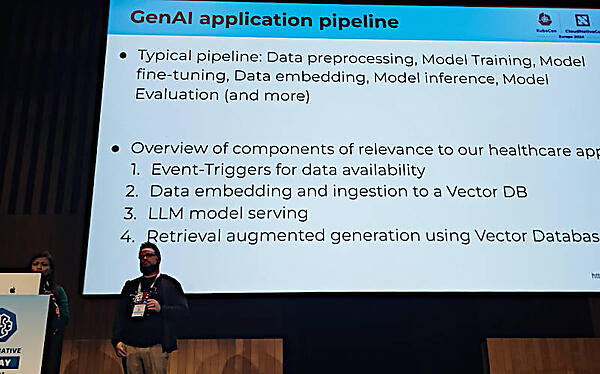

ここで機械学習においてはデータの整備、モデルの学習、モデルのチューニング、データの埋め込み、推論、モデルの評価などのプロセスが、パイプラインとして整備されていることが必須となることを説明した。

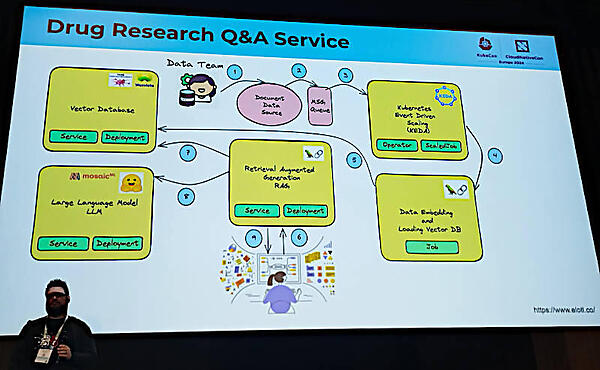

そして新薬開発のためのユースケースを想定して、エンドユーザーであるリサーチャーが対話型のアプリケーションを通じて生成型AIを使う場合のフローを紹介した。

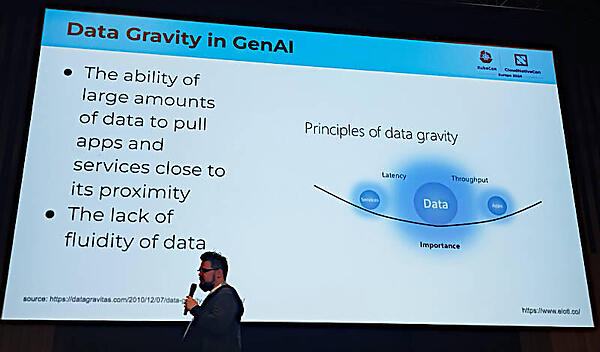

その際にデータベースが集約されているWebアプリケーションとは違い、その都度、大量なデータセットを用意する必要がある生成型AIのアプリケーションにおいてはデータがどこにあるのか? が重要になるとして、Data Gravityについて解説。ここではアプリケーションが必要とするデータをどうやって近接に持ってくるのか? が重要だという論点だ。

他の業界のアプリケーションと比べて、医療関連のシステムにおいて「データの近さ」が重要になることを業界の識者だと思われるTony Bishop氏のコメントを引用して説明している。遅延を想定すればどのアプリケーションでも遅延が少ないほうが好ましいのは当たり前だが、どうして医療関係においてそれが重要になるのか? という部分については特に説明がなかったのは残念である。

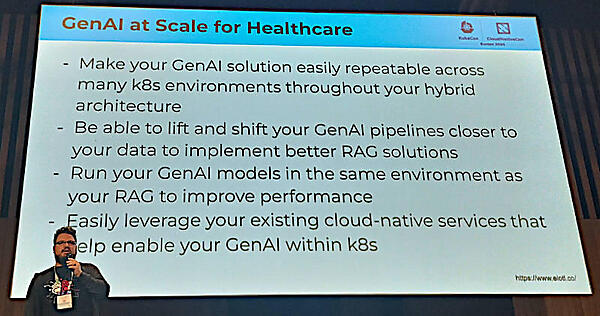

対話型で実行されるRAGアプリケーションにとって遅延は少ない方が良く、そのためにはデータの整備から始まるパイプラインも同様に近いデータセンターで処理されるほうが良いと説明。

そのためには1つのデータセンターに集約するのではなくマルチクラウド、オンプレミスとパブリッククラウドを想定して実装されることが重要だというのがRed Hatの論点だ。そのため透過的に複数のクラウドを操作できるFleet Managerのようなツールが必要となるというのがこのプレゼンテーションのゴールということだろう。

そして複数のクラウドを使い分ける簡単なデモを実施。ここではコマンドラインから操作し、複数のクラウドを使い分けていることを示した。

最後にまとめとしてELOTLのFleet ManagerのダウンロードサイトのURLを示しながら、複数のクラウドを使い分けることが遅延の少ないRAGアプリケーションにおいては重要であり、ELOTLのNovaはその候補になり得ることを説明してセッションを終えた。

全体としてELOTLのFleet Managerを使うことを前提として組み立てられており、単一のパブリッククラウドを使った場合との速度比較などがなかったのが残念だったと言えよう。RAGアプリケーションのようにユーザーが即座にその結果を手にすることができることが重要なアプリケーションの特性と、データのロケーションとの相関関係についてもっと深い解説をして欲しかった。

セッションの動画は以下から参照できる。

●動画:Gen-AI at Scale: Simplifying Orchestration of Healthcare Applications Across Multi-Cluster

- この記事のキーワード