KubeCon China 2024はAI_devという生成型AIに特化したカンファレンスも併催されていたために、多くの生成型AI及び機械学習関連のセッションが行われた。その中でも「GPUが障害を起こした時にどう対応するべきか?」という点に特化したセッションが複数行われていた。実際にはGPUが故障した場合には交換するなどの方法しかないわけだが、数十時間もかけて学習したデータセットをそのまま無駄にするのではなく、チェックポイントを取って別のGPUノードで継続するなどの対応が必要だ。

しかし実際にGPUノードの故障を待っているのではなく、Kubernetesのノードを疑似的に起動してそのアノテーションにエラーのステータスを設定して疑似的にエラーを起こし対応を試験するという方法が存在する。この稿ではKWOK(Kubernetes WithOut Kubeletの略)というKubernetesのSIGで開発が進められているツールの解説を、DaoCloudのエンジニアとNVIDIAのエンジニアが行ったセッションを紹介する。このセッションは会期2日目、2024年8月22日のキーノートセッションのひとつとして行われた。

KWOKの概要を説明

セッションのタイトルは「Supporting Large-Scale and Reliability Testing in Kubernetes using KWOK」、プレゼンターはDaoCloudのShiming Zhang氏とNVIDIAのYuan Chen氏だ。最初にDaoCloudのZhang氏によるKWOKの概要説明からセッションは始まった。

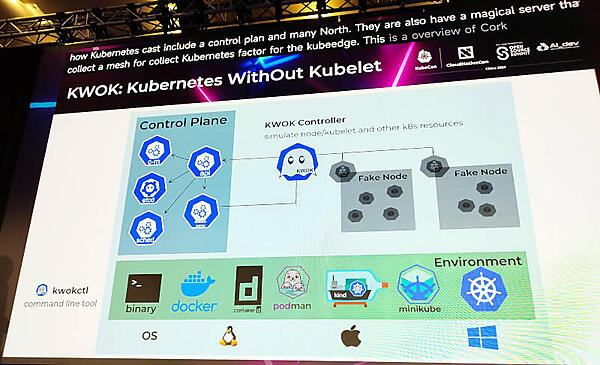

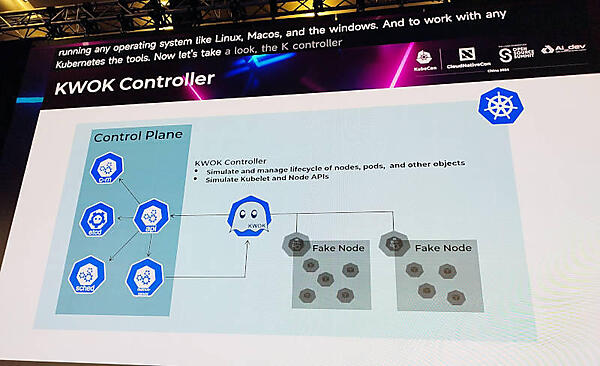

Kubernetesのクラスターはコントロールプレーンとワーカーノードで構成されるが、KWOKはコントロールプレーンに対して疑似的なノードの情報を与えることでコントロールプレーン上は数百台のノードが存在しているようにシミュレートするためのツールとなる。

KWOKのコントローラーがノードやPod、他のオブジェクトをシミュレートし、API経由でのアクセスも可能な構成を生成する。起動、終了などのライフサイクルもそのままシミュレートできるという。

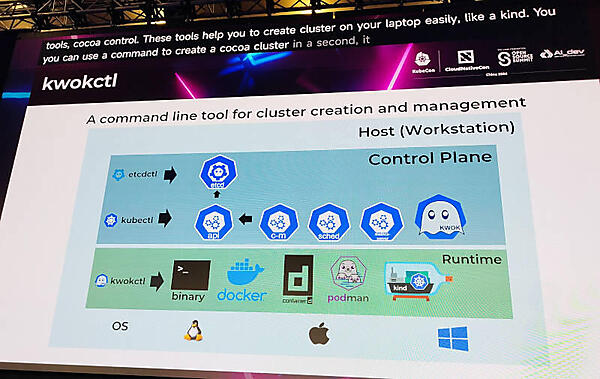

KWOKは上記のKWOK Controllerとkwokctlというコマンドラインツールから構成されているシンプルなツールのようだ。

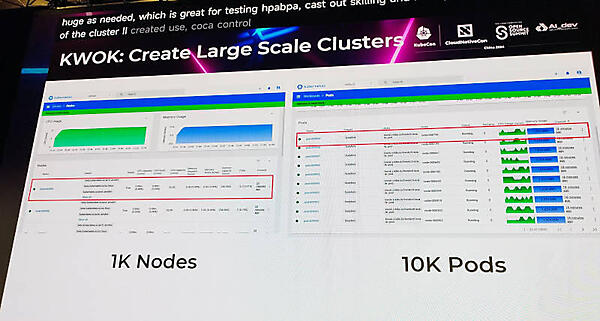

生成されるノード数は1,000、Podの数は10,000までとなっており、実際にステータスの画面を見せて説明を行った。

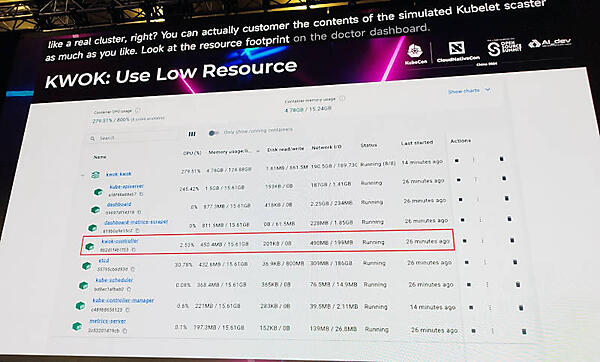

KWOKは同じ機能を実装した他のツールであるkubemarkと比べてKubeletを起動しないことから消費するリソースが少なく、ノードやPodの起動も高速であると公式サイトには解説が記載されている。

実際にkwokctlをターミナルで起動してクラスターのステータスを確認するなどのデモを挟んでサマリーを紹介。ここではKWOK Controllerとkwokctlの概要を説明してNVIDIAのChen氏に交代した。

障害耐久性は大規模GPUクラスターに必須

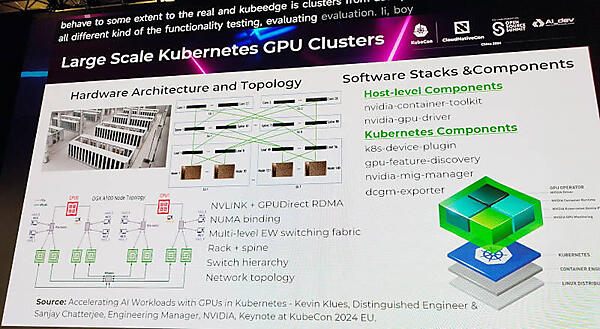

Chen氏は大規模なGPUクラスターの構成から説明を行い、ハードウェアのトポロジー、接続されるネットワーク構成、使われるコンポーネントなどを紹介。それをKubernetesから制御する際のコンポーネントまでまとめて解説を行った。

NVIDIAが公式に提供する各種ドライバーやツールなども紹介された。

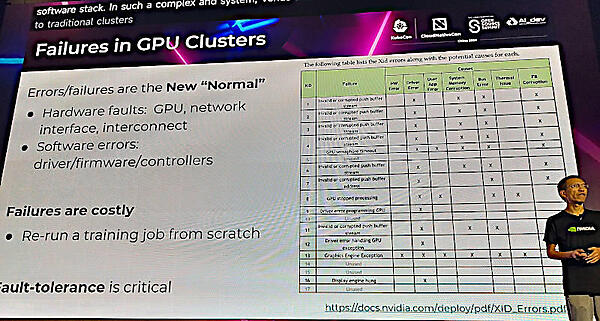

そしてGPUのクラスターにおいては障害、エラーが起こることはもはや当たり前であり、その前提を受け入れて欲しいと解説した。

障害耐久性をGPUクラスター運用の中に取り入れることが必須であり、そのためには障害が起こることを想定して対処方法を設計するべきと説明。そこで役に立つのがシミュレーションを実施するツールのKWOKであると解説した。

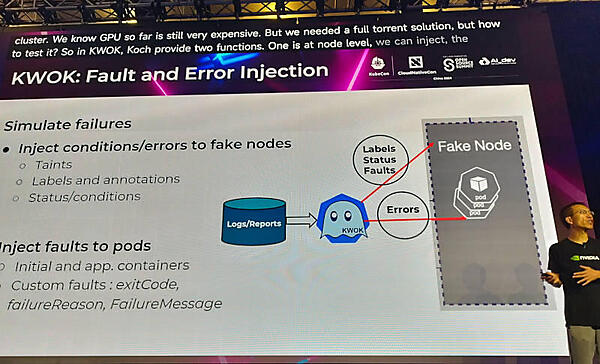

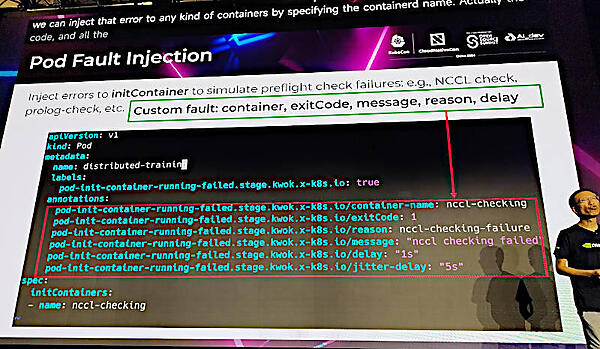

ノードやPodに対してエラーや終了条件をアノテーションとして追加することで、コントロールプレーンからはエラーと認識され、ジョブのリスケジューリングなどのシミュレーションを行えると説明した。

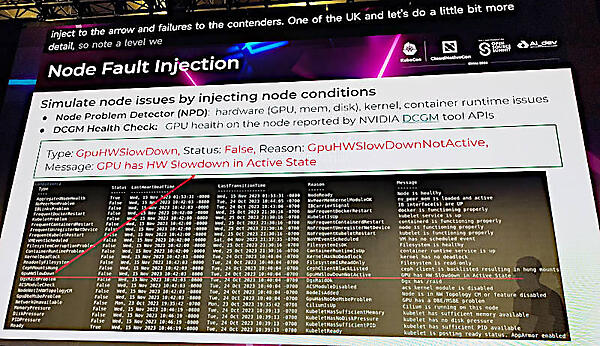

注入されたエラーはKubernetesのNode Problem DetectorやNVIDIA製ヘルスチェックで検知することを解説。

NCCL checkなどのツールで検知可能となり、Podの再実行などの対処方法を検証できる。

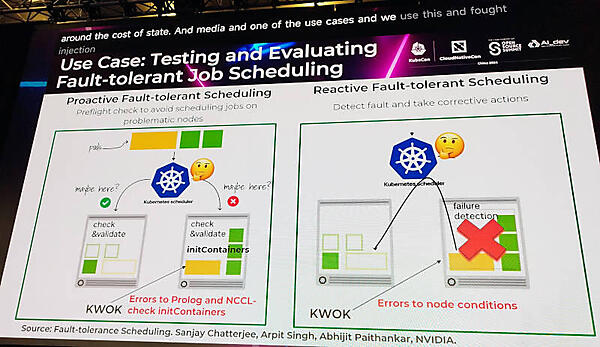

実際にKWOKを使ってエラーを起こす方法を2つのパターンで説明。ここではNVIDIA推奨のパターンとしてジョブがスケジューリングされる前のチェックの際にエラーを起こすパターンと、ノードにエラーのステータスを注入して対処を行うパターンが紹介された。

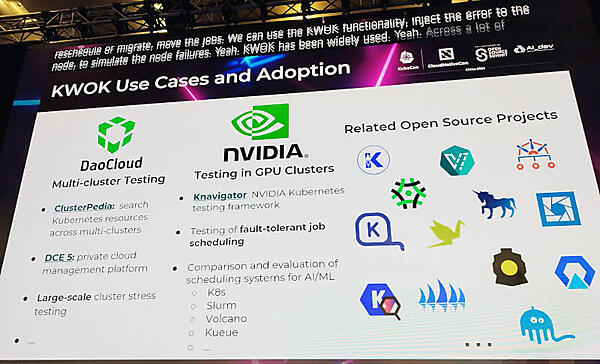

DaoCloudとNVIDIAのエンジニアがそれぞれ自社内でKWOKを使っていることを紹介。その他にも関連するツールを簡単に紹介した。

DaoCloudはd.runというNVIDIAのGPUクラスターを提供するサービスを持っているくらいにはGPUの経験に長けており、GPU関連のエラーが多いことをリアルに体験しているのは確実だ。そのDaoCloudのエンジニアとNVIDIAのエンジニアが揃ってKWOKを紹介したことが、このセッションのポイントだろう。

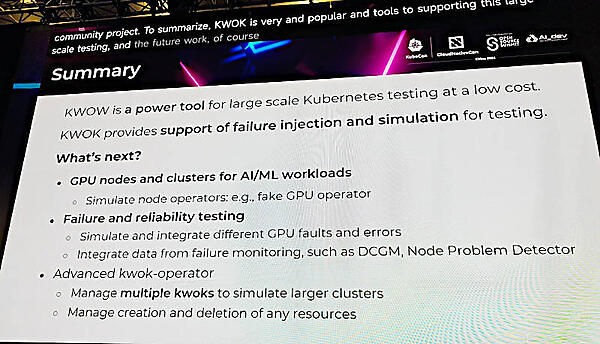

最後に今後の開発計画を簡単に紹介してセッションを終えた。

KWOKの公式ページは以下のサイトを参照して欲しい。貴重なGPUを無駄にせずに、だからと言ってペットのように扱うのではなく、エラーを起こしても対応できるクラウドネイティブなクラスター運用を目指すエンジニアは知っておいた方が良いツールだろう。

●公式ドキュメント:https://kwok.sigs.k8s.io/

このセッションは動画が公開されていないが、スライドは以下のリンクから参照可能だ。

●セッションのスライド(PDF):Large Scale and Reliability Testing in Kubernetes using KWOK