はじめに

あけましておめでとうございます。本年も「Gen AI Times」をよろしくお願いいたします。本連載は、生成AIコミュニティ「IKIGAI lab.」で活動している各分野の専門家が、それぞれの視点で生成AIに関する情報を発信しています。生成AIの活用がビジネス領域において本格化する中、理論と実践の両面から、最新の知見に基づいた実践的な情報をお届けします。

前回の記事「【生成AI進化の本質】いま起きている変化を技術と社会の両面から捉える」では、生成AIをめぐる変化を「技術」と「社会」の両面から整理しました。さらに「【あなたの仕事は“代替”される側?】生成AIによる効率化の先にある「人間の価値」」の記事では、効率化が進む中で、人が担う価値や役割の再定義を取り上げました。

これらをふまえ、今回は「AIが自律的に動く(エージェント化)」が実務機能として見え始めた2025年後半の動きを整理します。OpenAI、Google、Anthropic、Cursorの動きを横並びで見ながら、「推論→調査→操作」が統合されていく流れを俯瞰します。

エージェント機能が出現した2025年後半

2025年後半のアップデートで浮き彫りになったのは、各社が競っているのは単なる回答精度ではなく、推論→調査→操作を統合し、タスクを完結させる『エージェント能力』の実装であるという点です。AIはユーザーの問いに答える『便利な道具』という枠組みを超え、目的を与えれば自律的にプロセスを構築し実行する『デジタル・エージェント』へと、その存在定義を再構築し始めています。

主要各社の動向比較

| サービス代表モデル | 「推論→エージェント」の具体像 | 2025後半の主要トピック |

|---|---|---|

| ChatGPT GPT-5.2 | 調査から判断までの一気通貫 Deep Research機能により、数時間に及ぶウェブ調査、矛盾する情報の精査、そして最終的なレポート作成と意思決定支援までを自律的に完結させる | 2025年12月にGPT-5.2発表。2025年7月のブラウザ操作実装を経て、単なる回答ツールから「自律調査員」へと役割を定義し直した |

| Gemini Gemini 3 | アプリを跨ぐ実務の自律遂行 Google Workspace全体を操作対象とし「カレンダーから空きを探す→Meetを設定→関係者に案内を出す」といった、アプリの境界を越えた連続的な実務代行を行う | 2025年11月にGemini 3発表。 Deep Thinkによる論理構築とWorkspace各機能の「直接操作」を統合した実務フローを確立 |

| Claude Claude 4.5 Opus | PC画面の直接操作と完遂能力 Computer Use機能により、ブラウザやローカルアプリなど、人間と同じようにGUIを認識・操作する。専門的なコーディングやSaaSを横断する複雑な事務作業を「完遂」する | 2025年11月にOpus 4.5発表。開発者向け「Claude Code」を含め、プロフェッショナルな実務を「代わりに終わらせる」能力に特化 |

| Cursor Cursor 2.0 | マルチエージェントによる並列開発 Composer機能を核に複数のAIエージェントが各作業領域でコードを書き進める。AI同士が互いの成果をコードレビューし合い、人間は「承認」のみを行う環境を提供 | 2025年10月にVer 2.0リリース。複数のモデルを競わせ、最も精度の高いコードを選択する「マルチモデル競争・審査」機能を実用化 |

【出典】「Agents | OpenAI API」

【出典】「Gemini API ドキュメント」

【出典】「Computer use tool - Claude Docs」

【出典】「Cursor Agent 概要」

【出典】「Cursor 並列エージェント(Worktrees」

「高機能」=「使える」ではない現実

このように「推論・調査・操作」を代替する機能(能力)は、すでに私たちの手元に揃っています。にもかかわらず「期待通りに動かない」「プロセスが不透明で制御不能になる」「結局、人間の手直しが減らない」という声が後を絶ちません。

ツールが高度化する一方で、なぜ実務への浸透が難しいのでしょうか。この「機能と実用の断絶」を生んでいるボトルネックを解明します。

なぜAIを使いこなせないのか?:「前提」の欠如

一因は、私たちがまだAIを「検索窓の延長」として扱いがちな点にあります。

「質問」の時代から「前提」の時代へ

これまでのAI活用は「いかに上手に質問するか(プロンプト)」が中心でした。しかし、エージェント型のAIに対しては、手順を細かく縛るほど、かえってズレが増える場面があります。

エージェント型AIに仕事を任せるのは、人間の部下に「いい感じにやっといて」と頼むのと同じです。ここで必要なのは、操作手順のような「細かい指示」ではなく、「いい感じ」の中身、つまり目的・制約・評価軸といった判断基準(コンテキスト)の共有です。これが渡っていないとAIは方向性を見失い、現場の期待と出力の間に大きな「ズレ(ギャップ)」が生まれてしまいます。

わずか「6%」の企業しか成功していない現実

この「ズレ」の深刻さを物語るデータがあります。ハーバード・ビジネス・レビュー(HBR)が報じた調査によると、AI投資で実際にビジネス価値を生み出せている企業は、わずか6%に過ぎません。

成功している6%の共通点は、AIの性能に頼るのではなく「プロセスの書き換え(Rewiring)」を行っている点です。ここでいう「成功」とは、PoCで終わらせず、AI投資を実際の業務・事業に組み込み、継続的に価値(コスト削減や売上貢献など)を生み出し、全社でスケールできている状態を指します。つまり、AIが迷わず動けるように「仕事の前提(コンテキスト)」を再設計した企業だけが、その状態を掴んでいます。

このように、自律型AIに必要なのは微細な指示という名の「マイクロマネジメント」ではなく、正しく決断させるための「外的文脈(コンテキスト)」という指針なのです。誰が読んでも、どのAIが考えても、迷わず同じ判断ができるような「一義的な前提(コンテキスト)」を整えてあげることが重要になってきます。

【ケーススタディ】実験:

AIに「ことわざ」を証明させてみた

「コンテキストの欠如」がどれほど致命的かを、1つの小さな実験で確かめてみます。

題材にするのは「二度あることは三度ある」と「三度目の正直」という相反することわざです。ここでは「ことわざとしてどちらが正しいか」を決めたいのではなく、前提(コンテキスト)と判断軸を与えると、AIの結論がどう変わるのかを見ます。具体的には、まずフェーズ1で「前提なし」のまま質問し、次にフェーズ2で「前提(コンテキスト)と判断軸(=強い/弱いの定義)を固定」したうえで、「数学的にどちらの主張が強いか」という形で検証します。

この実験の狙いは、前提の与え方1つで回答が「一般論」から「意思決定に使える判断」へ変わることを可視化する点にあります。なお、検証には「ChatGPT 5.2 Thinkingモード」と「Gemini 思考モード」を用いました。

フェーズ1:前提なし(一般論に収束する)

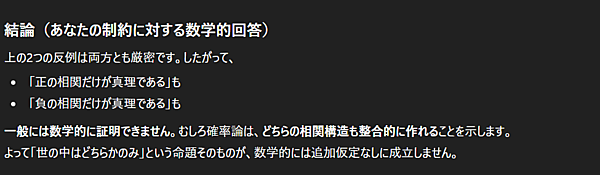

AIに「『二度あることは三度ある』と『三度目の正直』、数学的にはどちらが正しいか?」と問いかけます。返ってくるのは、以下のような「追加仮定なしには決められない」という一般論です。

これは、こちらが前提を決めていないために、AIが「無難に言えること」しか言えない状態です。たとえるなら、相手に目的や条件を伝えずに相談した結果、「場合によります」と返されるのと同じ構造です。

しかし、実務で本当に意思決定を左右するのは「状況」そのものです。目的、守るべき制約、そして「何を正解とするか」が共有されていないと、AIは安全な「平均解」として、誰にでも当てはまる一般論しか返せません。

フェーズ2:前提あり(判断が“現場仕様”に変わる)

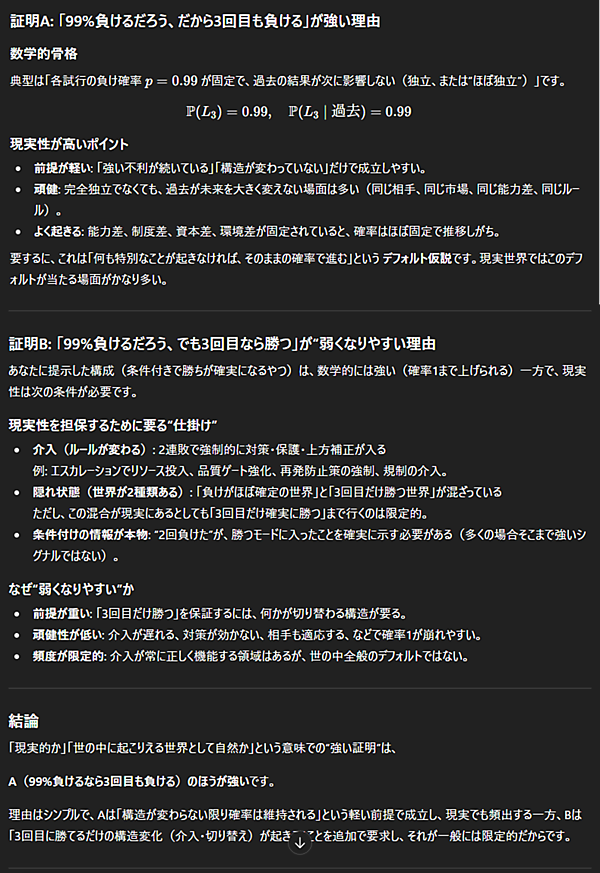

フェーズ2は、フェーズ1から会話を継続した状態で、問いの形式を「判断を下せる形」に再定義しました。

単なる「ことわざの正誤当て」では、追加の情報(前提)なしに正解は出せないので、ことわざの構造を『「A」(二度あることは三度ある) vs 「B」(三度目の正直)』 という2つの主張として置き直し、さらに「強い=現実的に起こりやすいのはどちらか」という判断基準を固定して比較させました。

ここで見たいのは、ことわざの正解ではなく、具体的な前提と判断基準を渡すとAIの答えが「一般論」から「意思決定に使える判断」に変わるのかという点です。

この場合のAIからの回答は以下のとおりでした。フェーズ1では「追加仮定なしには決められない」という一般論に収束しましたが、フェーズ2では前提(コンテキスト)を与えたことで、結論が明確に変わりました。AIは「A(99%負けるなら3回目も負ける)のほうが強い」と判断したのです。

AIの回答を要約すると「『現実的に起こりやすい』という意味で強いのはA(負け続ける)で、理由はAが『構造は変わらない』という軽い前提だけで成立する一方、B(3回目に勝つ)は『勝てるだけの構造変化(介入・切り替え)が起きる』という追加条件を要求するから」です。

つまり、AIは「ことわざの正解」を当てにいっているのではなく、こちらが与えた判断軸(現実的かどうか)と前提(構造が変わらない/変わる)に沿って結論の強弱を組み立てています。逆にBを成立させたいなら「どんな介入で勝率が上がるのか」まで含めて、前提をこちらが具体化して渡す必要があります。

実験から得られた戦略的示唆:AIは「前提」の鏡である

この実験が明らかにしたのは、AIが自ら正解を導き出しているのではなく「与えられた前提(コンテキスト)」に合わせて答えを動的に生成しているという数理的な構造です。

- AIに「真実」はない:AIは「この状況では何が正しいか」を自分で決める存在ではありません。与えられた目的や条件に沿って、もっともらしい筋道を組み立てて答える仕組み

- AIは前提に強く影響される:目的・制約・評価軸がはっきりしていれば結論も具体化しますが、前提が曖昧だと「場合によります」「追加情報が必要です」といった一般論に寄りやすくなる

- 主導権は人間にある:AIに任せるほど「何をゴールにするか」「何を守るか」「何を捨てるか」を人間が先に言語化する必要があります。これがないと、AIは安全側に倒れて役に立つ判断まで踏み込めない

結論として、AIと共生するフェーズでは、単に「どう聞くか(質問)」以上に「どのような土俵で考えさせるか(前提)」の設計が成果を大きく左右するのです。

ここで思い出したいのが、BCGが示す「10/20/70ルール」です。BCGによれば、AI活用の成否はアルゴリズム(10%)やテクノロジー/データ(20%)だけで決まるのではなく、残りの70%は「人とプロセス」によって決まる、と整理しています。言い換えるなら、AIの出力を実務で「使える形」に収束させる鍵は、モデルの賢さではなく、前提(コンテキスト)を言語化する、人間の設計能力に他ならないのです。

【解決策】エージェントを駆動する

「コンテキスト・エンジニアリング」

AI活用の成功を握る7割の工数は、プロンプトの微調整ではなく「前提条件(コンテキスト)」の設計にあります。エージェントに「作業の進め方」を丸投げするのではなく、正しく決断させるための「判断基準(評価軸/優先順位)」を設計する。この「コンテキスト・エンジニアリング」の実践フレームワークを定義します。

コンテキスト設計の「4つの要素」

エージェントが自律的に動く際に、判断の「ズレ」を最小化し、成果を狙った方向に収束させるための基本項目です。

- Role(役割):どの立場で判断するか、何を優先するか(例:CFO視点でリスク最優先/SRE視点で安全最優先)

- Context(背景):判断に必要な前提情報(過去の失敗、技術負債、顧客事情、使えるデータ・資料など)

- Constraints(制約):守る条件と、やらないこと(予算・納期・禁止事項・権限範囲など。迷いどころを先に潰す)

- Success(成功条件):何が出たら完了か(成果物の形式、判断基準、レビュー観点まで含めて明確化)

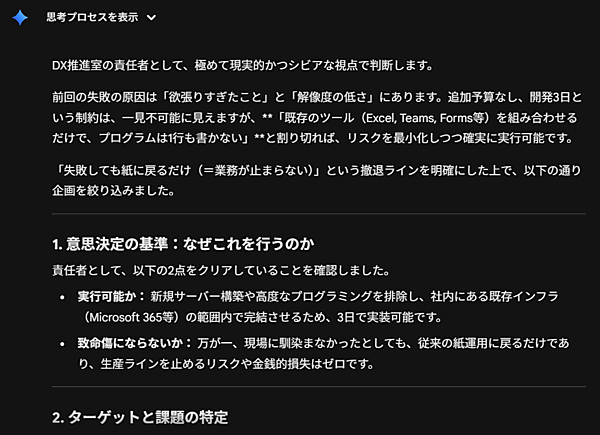

■ 実装例:新規事業の「MVP(最小機能)」を定義する

例えば、製造業の情報システム部門やDX推進室で「現場の業務を楽にする新サービスを作りたい」と考えたとき、担当者がAIに「新規事業の案を出して」と投げがちです。

しかし、この指示では目的や前提が曖昧なままなので、解釈がブレやすくなります。コンテキスト・エンジニアリングでは、次のように前提条件(コンテキスト)を先に明示して、判断のズレを防ぎます。

【コンテキスト記述例】リスクを最小化したい責任者として振る舞ってください。(Role:役割)「実行可能か」「失敗したときに致命傷にならないか」を最優先で判断してください。

過去に似た企画を出しましたが、目的と対象が曖昧で、社内合意が取れずに頓挫しました。今回は「誰の、どんな困りごとを、どう解決するか」を明確にしたいと考えています。(Context:背景)

今回は、追加予算なし・開発期間3日という極めて厳しい不確実性下での検討となります。できることは最小限に絞り、不要な機能はすべて捨ててください。(Constraints:制約)

最終的に、「対象ユーザー」「解決する課題」「最小機能(MVP)」が1枚で説明でき、チーム全員が同じ解像度で次の一歩に踏み出せる状態をゴールとして提示してください。(Success:成功条件)

このように前提を先に固定すると、AIの回答は「場合によります」という一般論から脱し、制約と成功条件に沿った「現場で使える提案」へ収束しやすくなります。結果として、次のアクション(試作・検証)に移りやすくなります。

【まとめ】AIと働く作法は

「プレイヤー」から「ディレクター」へ

ここまでの整理を踏まえると、AIの回答精度はモデル単体で決まるのではなく「目的・背景・制約」といった前提の解像度に左右されるという構造です。同じ問いでも、コンテキスト(前提)を人間がどう設計するかで、出力は「無難な一般論」にも「鋭い意思決定の判断」にも変わり得ます。

これをふまえると、今後も進化していくAIを使いこなすには、上手に聞くための「質問(プロンプト)」を磨くこと以上に、AIが迷わず判断・実行できるように、仕事の前提(目的・背景・制約・評価軸)を一義的に設計(エンジニアリング)することが重要になります。

2026年は、複雑な作業をAIが解ける形に分解し、判断に必要な前提(目的・背景・制約・評価軸)を言語化する。そのための「4つの要素(Role/Context/Constraints/Success)」を伝えられるかが、AIを「使える形」に収束させる分岐点になると考えられます。