省電力によるコスト削減

空調に関する省電力

空調の効率化に関する取り組みは、冷気を作り出す「空調機」の開発と、空調機が作り出した冷気を効率よくサーバールームに循環させる「気流設計」の2つの方向から進められている。

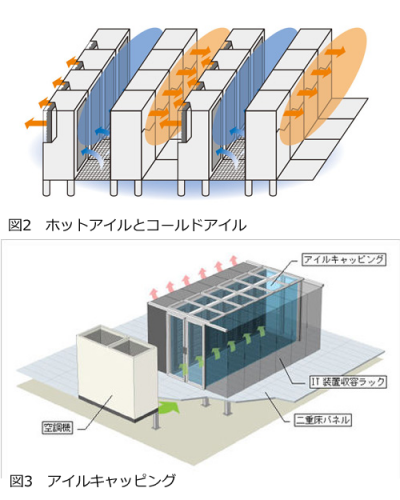

現在一般的なデータセンターの気流設計は、サーバールームの床を二重床とし、冷気はまず床下を通ってラック前面の通路から吹き出す。この冷気がラック前面から吸気され、ラック背面に排気される。ラック列はそれぞれ、前面同士/背面同士が向かい合うように配列され、前面側の通路が「コールドアイル」(Cold Aisle)、背面側の通路が「ホットアイル」(Hot Aisle)と呼ばれる。空調の制御では、まずコールドアイルの気温を一定レベル以下に維持することが主眼となる。次いで、ホットアイルの熱気がコールドアイルに回り込むことを防ぎ、熱気を確実に取り除いて冷却器に送り込むことで効率を高めることができる(図2)。

国内データセンターファシリティに長年の実績を持つNTTファシリティーズの研究によれば、冷却器から二重床に送り込まれる冷気の気流は一様に流れるわけではなく、通路の太さ(二重床の高さ)と長さ(冷却器からの距離)の相関関係によって圧力差が生じるという。さらに、この圧力差は冷却器に近い方が圧力が高いという単純なものではなく、床高が高く距離が短い場合は空調機から遠い場所で圧力が高くなり、床高が低く距離が長い場合は空調機に近いところの圧力が高くなる。二重床の上面から冷気が吹き出すとき、圧力が高い個所からはより多くの冷気が吹き出すことになる。そのため、冷気吹き出し口を均一に設けるのではなく、二重床内の気流圧力を意識して吹き出し口の配置密度を調整することで、冷気の吹き出し量を最適化することも可能になる。

圧力が低い個所では冷気の吹き出し量も減少するため、この場所に発熱量の多いラックを配置してしまうと冷却能力が不足することになり、結果として冷却器の運転強度をより高めてやる必要が生じる。逆に、冷気が大量に出てくる場所に発熱量の多いラックを配置し、冷気が少ない場所に発熱量の少ないラックを配置すれば、冷却器の能力を無駄なく活用できることになる。

熱気が空調機まで戻る経路となる、ホットアイルの天井にも同様のことがいえる。天井裏の気流通路の高さや距離を踏まえ、発熱量の多いラック近傍でより多くの排気を引き込むように設計すれば、排熱をマシンルームから効果的に取り除くことが可能になる。

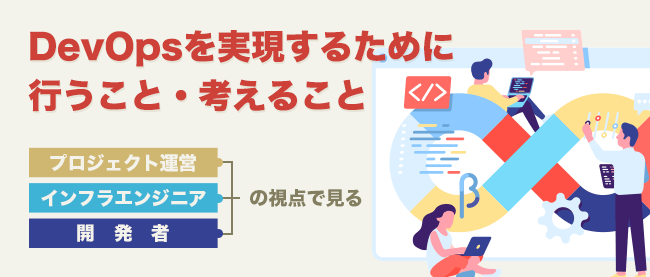

気流設計の最終的なゴールと位置づけられているのが、「アイルキャッピング」(Aisle Capping)だ(図3)。これは、コールドアイルの周囲に囲いを設けて密閉状態にしてしまうことで、コールドアイルの冷気が無駄なくラック内に流れていくようにし、さらにホットアイルからの熱気がコールドアイルに回り込むことを防ぐことができる。冷却器が作り出した冷気を無駄なく目的のラックに届けることが可能になり、効率を最大限に高めることが可能だ。

高効率な空調機

NTTファシリティーズの気流設計の技術は、NTTグループの研究所でのNGNの研究成果がもとになっているという。NGNに関する研究開発に着手した際に、大きなテーマの1つとなったのが、機器の効率的な冷却技術である。これは、NGNでは高速で高機能なルーターを高密度で集積するため、効率のよい冷却手段が必要となったためだ。この研究成果として得られたのが気流設計の技術で、同社ではこの技術をデータセンターに応用し、効率化を実現している。

同社では、気流設計の観点から「空調ベストプラクティス」をまとめ、コンサルティングなどで活用している。同社によると現在の一般的なデータセンターで画一的なパネル配置にした場合のPUEが1.90なのに対し、同社の最新の空調機「FMACS」を使用し、二重床設計と天井設計を最適化し、さらにアイルキャッピングを併用することで、最終的にPUE 1.45を実現できるという。

同社がまとめた「空調ベストプラクティス」によれば、発熱量が20kWを超えるラックが存在しない場合は、現状の画一的なパネル配置でPUE 1.90、冷却器に同社のFMACSを採用し、さらに二重床での気流設計ノウハウを投入することでPUE 1.55、天井での気流設計を加えることでPUE 1.50、アイルキャッピングを併用することでPUE 1.45が達成できるとしている。さらに、発熱量が20kWを越えるラックが混在している場合は、局所冷却技術である「タスクアンビエント空調方式」を併用することで同じくPUE 1.45が実現可能だという。同社ではラック当たりの発熱量に関して、これらの技術によって35kW程度までなら対応可能だと予測している。ラック当たりの発熱量が35kWを超える場合には、空冷での対応は困難となり、液冷(Liquid Cooling)の導入が必要だと予測している。サーバーの実装密度は向上を続けており、ブレードサーバーが拍車を掛けている状況だが、現在の一般的なデータセンターでのラック当たりの最大電力供給量の平均は4kW~6kWと、まだ20kWを越えていないことが大半であることを考えると、今後数年程度は空冷のみの対応でも問題ないといえるだろう。